티스토리 뷰

목차

활성화 함수(Activation Functions) 이해하기

손실 함수(Loss Functions)의 역할과 중요성

확률적 경사 하강법(Stochastic Gradient Descent, SGD)

합성곱 신경망(Convolutional Neural Network, CNN)

순환 신경망(Recurrent Neural Network, RNN)

순환 신경망의 발전(The Evolution of RNN)

Introduction

인공지능(AI)이 사회 곳곳에 깊숙이 자리 잡으면서 그 결정이 우리 일상에 중대한 영향을 끼치고 있다.

이에 AI의 결정 과정을 이해하고, 그 근거를 파악할 수 있는 '설명 가능한 AI(XAI)'의 필요성이 커지고 있다.

XAI는 AI의 '블랙박스'를 들여다보게 하여, 사용자가 AI의 예측과 결정을 신뢰할 수 있도록 하는 것이다.

예를 들어, 의료 영상 판독에서 AI가 진단을 내렸다면,

그 근거가 되는 영역을 시각적으로 보여주어야 의사와 환자 모두가 AI의 결정을 이해하고 수용할 수 있다.

XAI in Image Domain

이미지 분야에서의 XAI 기술은 주로 모델이 특정 결정을 내리기까지 어떤 영역에 주목했는지를 시각화한다.

Class Activation Map(CAM), Attention, Activation Maximization 등은 모델의 '시선'을 드러내는 기술들이다.

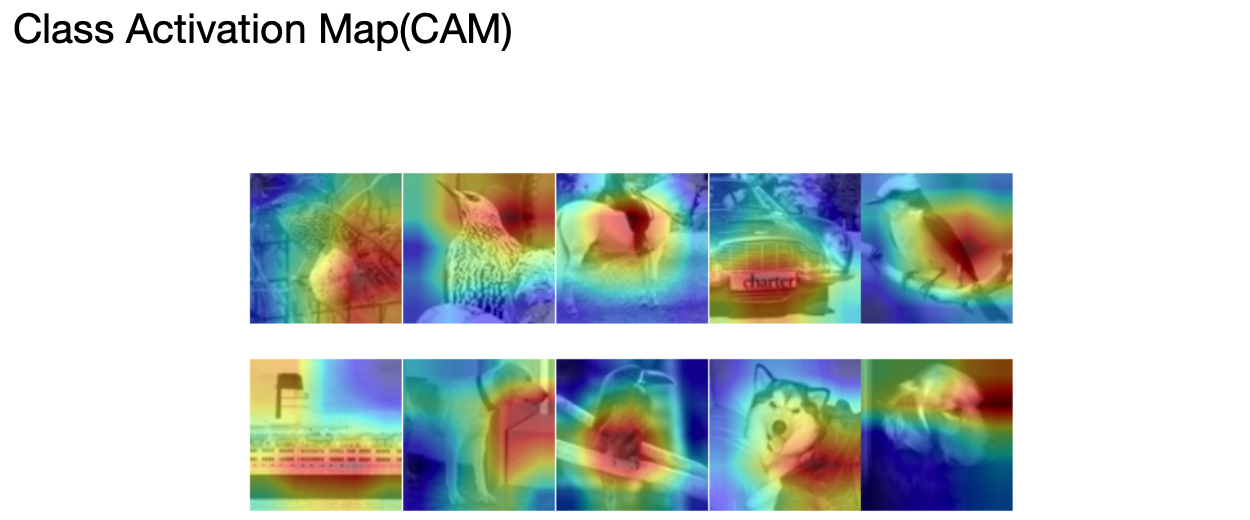

CAM은 이미지 내의 특정 부분이 특정 클래스의 판별에 얼마나 기여했는지를 보여주는 열지도(heatmap)를 생성한다.

Attention 메커니즘은 모델이 특정 정보에 집중하는 과정을 시각화하여, 모델이 '주목'하는 지점을 밝힌다.

Activation Maximization은 각 특징을 가장 활성화시키는 이미지를 생성하여,

모델이 어떤 패턴을 학습했는지를 이해하는 데 도움을 준다.

CAM and Its Variations

CAM은 모델이 어떤 부분을 보고 결정을 내렸는지를 알 수 있게 해주는 기술로,

특히 CNN(Convolutional Neural Network)의 마지막 합성곱 계층(convolutional layer)과 연결된 가중치를 사용하여,

각 클래스에 대한 지도를 만들어낸다. 이를 통해 모델이 어떤 부분을 중요하게 생각하는지를 열지도로 나타낸다.

Grad-CAM은 CAM의 한계를 개선한 기술로, 더 다양한 CNN 모델에 적용 가능하고, 더 세밀한 영역을 강조한다.

Guided Grad-CAM은 Grad-CAM과 Guided Backpropagation을 결합하여 더 명확한 시각적 설명을 제공한다.

Further Necessities and Prospects of XAI

XAI 기술은 단순히 모델이 '어떤 것을 보았는가'를 넘어서 '왜 그것을 보았는가'에 대한 설명을 제공해야 한다.

또한, XAI는 법적 규제, 윤리적 책임, 그리고 사용자의 신뢰 구축 등의 관점에서도 중요하다.

향후에는 XAI 기술이 더욱 발전하여, 인간과 AI 간의 상호작용을 더욱 원활하고 투명하게 만들 것으로 기대된다.

Conclusion

이렇게 XAI는 모델의 내부 작동 원리를 이해하고, 이를 바탕으로 모델을 개선하며,

최종적으로 사용자의 신뢰를 확보하는 데 필수적인 역할을 한다.

우리는 AI의 결정에 영향을 받는 세상에서 살고 있으며, 그 결정이 공정하고 정확하다는 것을 알 권리가 있다.

XAI는 그러한 권리를 실현하는 기술이다.

'ML+DL > Deep Learning' 카테고리의 다른 글

| 딥러닝 학습 방법: 지도학습부터 강화학습까지 (0) | 2024.04.13 |

|---|---|

| 전이 학습(Transfer Learning) (0) | 2024.04.12 |

| 딥러닝 모델 튜닝: 성능 향상의 기초와 전략 (0) | 2024.04.12 |

| 데이터 불균형 (0) | 2024.04.12 |

| 과적합과 그 방지법 (0) | 2024.04.11 |

| 생성적 적대 신경망(Generative Adversarial Network, GAN) (0) | 2024.04.11 |

- Total

- Today

- Yesterday

- 유럽여행

- Algorithm

- 동적계획법

- 여행

- spring

- RX100M5

- 리스트

- 기술면접

- 자바

- a6000

- 중남미

- 면접 준비

- 세모

- 세계여행

- 파이썬

- Backjoon

- 백준

- 스프링

- 지지

- 스트림

- java

- 알고리즘

- 칼이사

- 유럽

- 맛집

- 야경

- BOJ

- 남미

- 세계일주

- Python

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |