티스토리 뷰

목차

활성화 함수(Activation Functions) 이해하기

손실 함수(Loss Functions)의 역할과 중요성

확률적 경사 하강법(Stochastic Gradient Descent, SGD)

합성곱 신경망(Convolutional Neural Network, CNN)

순환 신경망(Recurrent Neural Network, RNN)

순환 신경망의 발전(The Evolution of RNN)

Introduction

딥러닝의 순환 신경망(RNN)은 연속적인 정보를 다루는 데 혁명을 일으켰다.

여기선 RNN이 어떻게 시간의 흐름을 포착하는지, Vanilla RNN의 한계는 무엇인지,

그리고 LSTM, GRU 같은 발전된 모델이 이를 어떻게 극복했는지 살펴본다.

또한 seq2seq와 어텐션 메커니즘을 통한 혁신까지, RNN의 진화를 간결히 풀어서 설명한다.

Vanilla RNN

Vanilla RNN은 시퀀스 데이터를 처리하기 위한 가장 기본적인 형태의 순환 신경망이다.

이 구조는 이전 상태의 정보를 현재 상태의 결정에 사용하여 시퀀스의 순서를 모델링한다.

Vanilla RNN의 각 단계에서 입력 x(t)와 이전 상태 h(t−1)가 결합되어 현재 상태 h(t)를 생성한다.

하지만 이 구조에는 결정적인 단점이 두 가지 있었는데, 바로 기울기 사라짐과 장기 의존성이다.

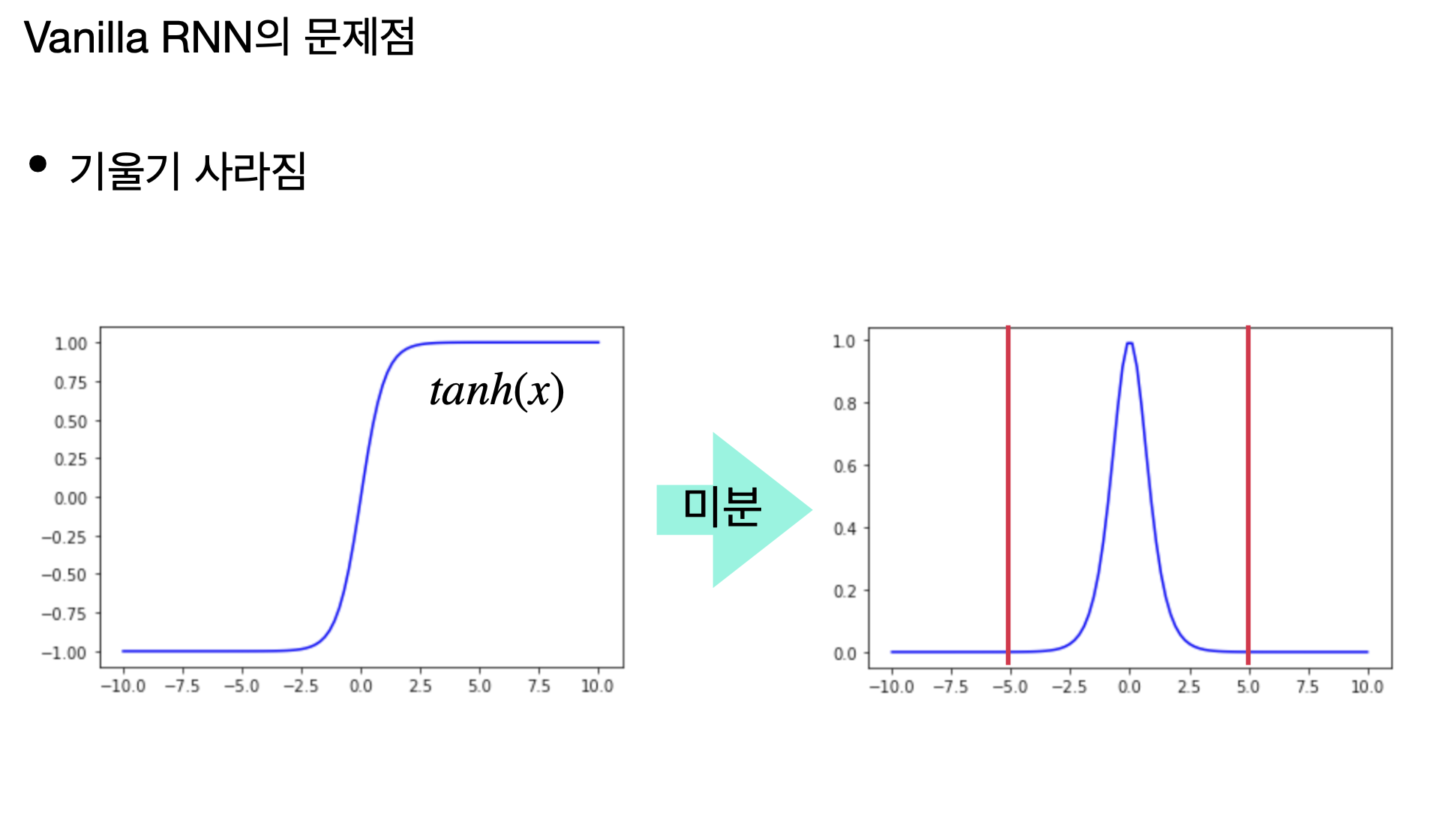

Gradient Vanishing: The Dilemma

Vanilla RNN은 기울기 사라짐 문제를 가지고 있다.

이는 네트워크가 깊어질수록 또는 시퀀스가 길어질수록 경사(미분 값)가 점점 작아져

학습이 제대로 이루어지지 않는 현상을 말한다.

이로 인해 네트워크는 장기 의존성을 학습하는 데 어려움을 겪는다.

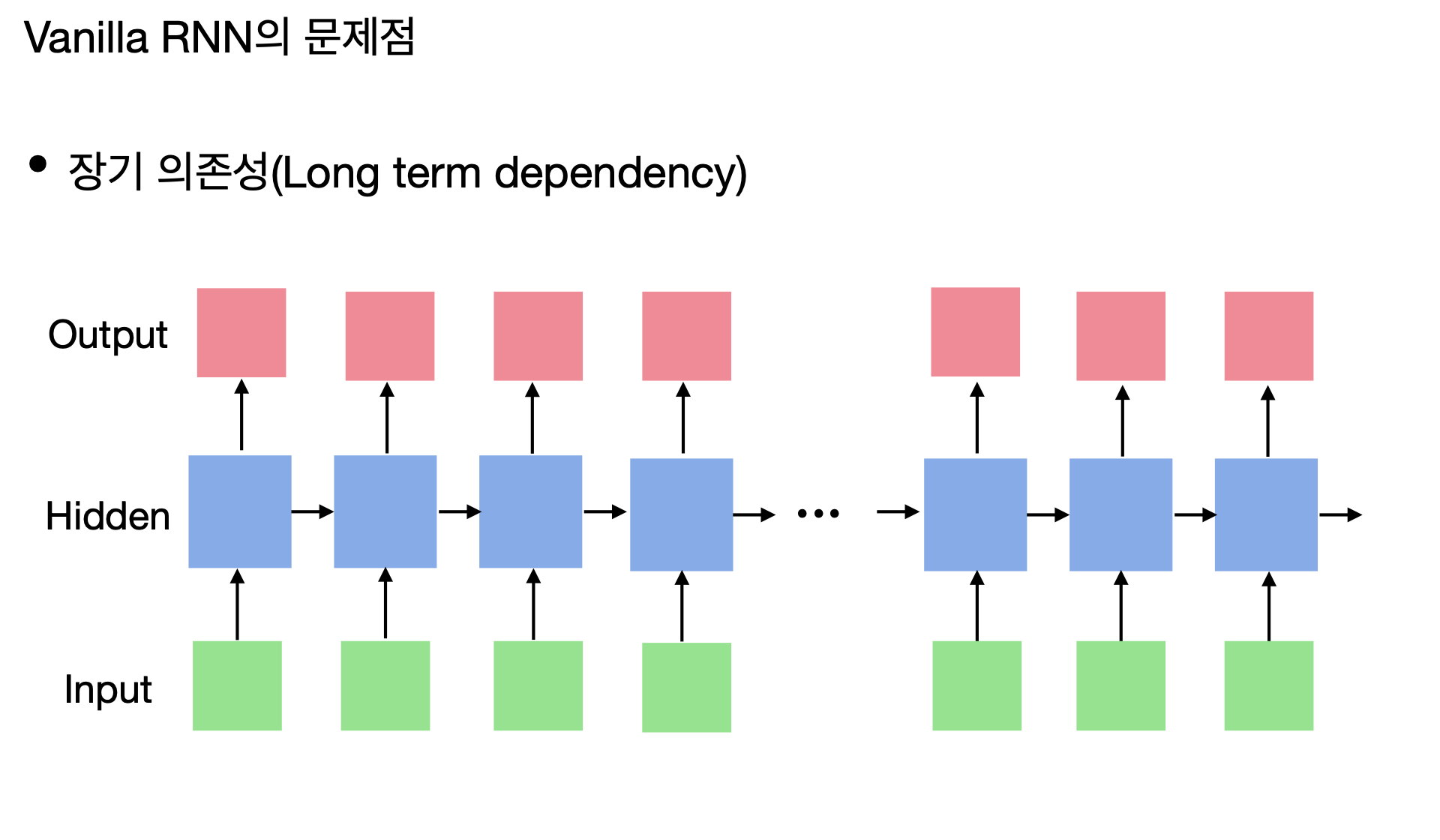

Long Term Dependency: The Challenge

Vanilla RNN의 또 다른 문제점은 장기 의존성을 다루는 데 한계가 있다는 것이다.

즉, 입력 시퀀스가 길어질수록 시퀀스의 앞부분 정보가 뒷부분에 영향을 미치기 어렵다.

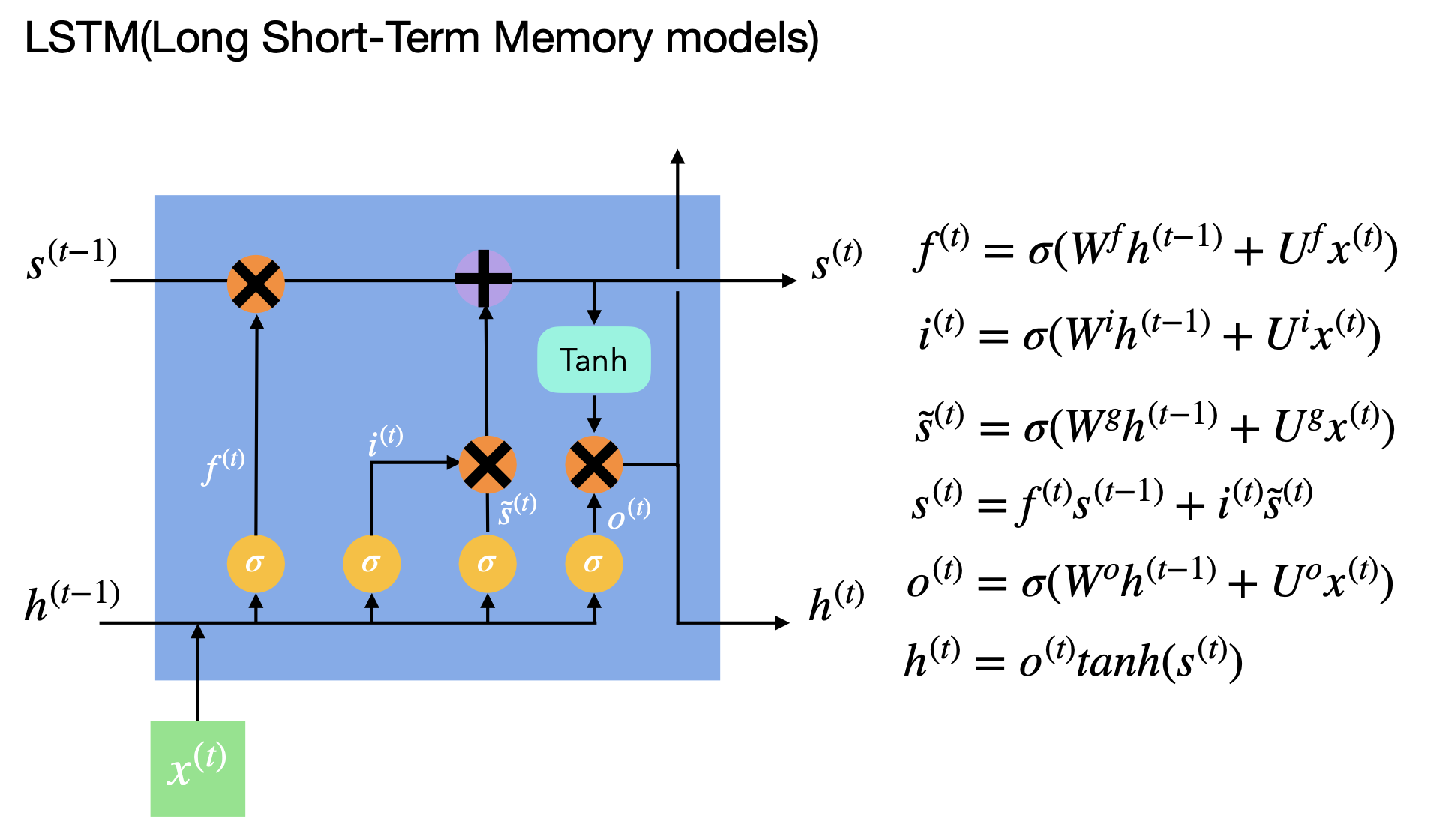

LSTM: The Breakthrough

LSTM(장단기 메모리)은 Vanilla RNN의 한계를 뛰어넘어 기울기 사라짐 문제와 장기 의존성을 해결한 획기적 모델이다.

이 구조는 게이트를 통해 정보의 저장과 삭제를 결정하며, 이를 통해 필요한 정보를 장기간 기억한다.

LSTM은 각 게이트의 역할을 수행하기 위해 여러 매개변수와 활성화 함수를 사용한다.

예를 들어, '잊기 게이트'는 불필요한 정보를 잊고, '입력 게이트'는 새로운 정보를 현재 상태에 추가하는 역할을 한다.

또한, '출력 게이트'는 다음 상태로 전달될 정보를 결정한다.

이처럼 복잡한 구조를 통해 LSTM은 시퀀스 데이터를 보다 효과적으로 처리할 수 있으며,

자연어 처리와 같은 분야에서 괄목할 만한 성과를 내고 있다.

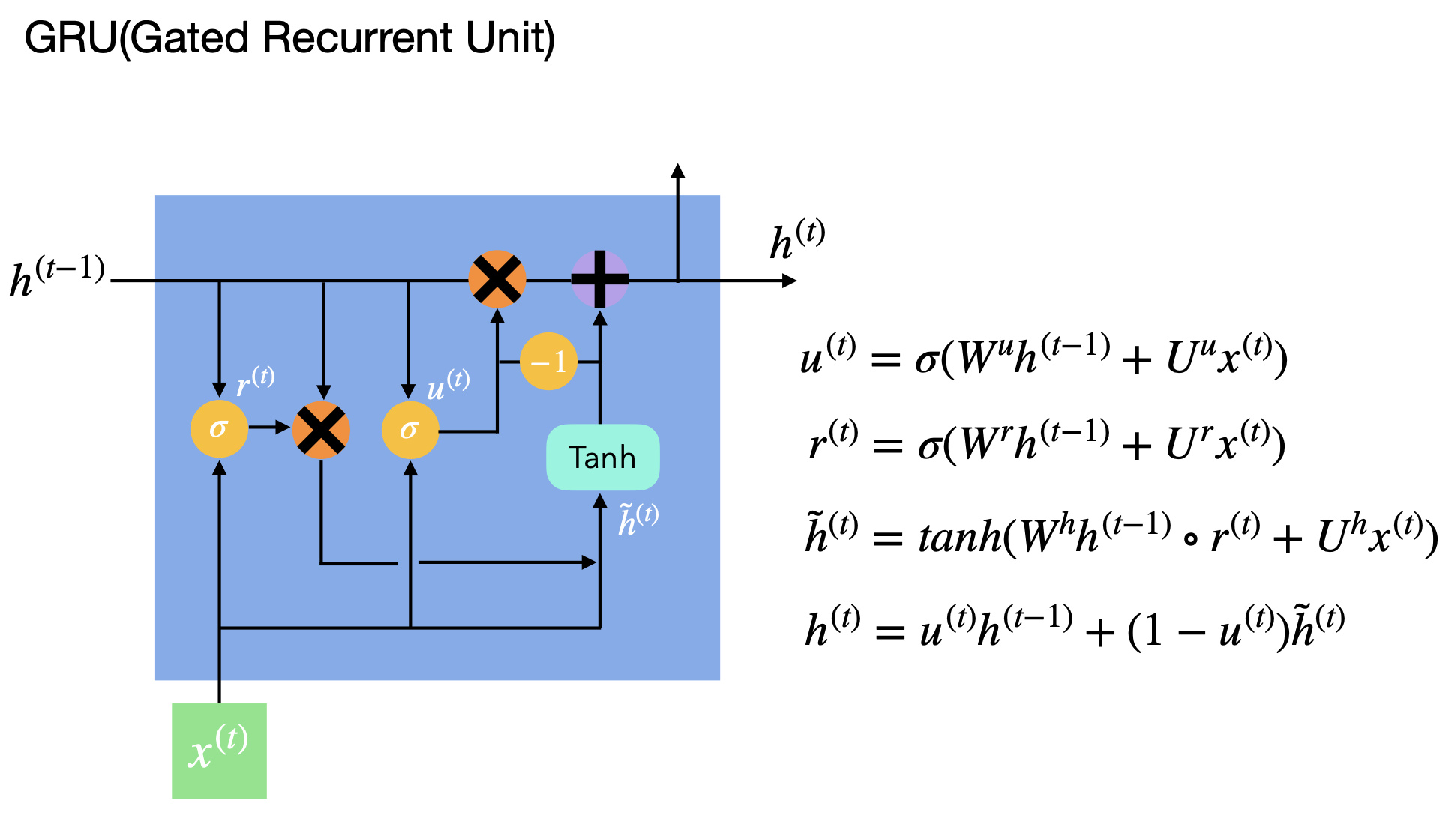

GRU: The Simplification

GRU(게이트 순환 유닛), 즉 Gated Recurrent Unit은 순환 신경망의 한 형태로,

LSTM의 복잡한 구조를 간결하게 만들어낸 모델이다.

이 모델은 업데이트 게이트와 리셋 게이트라는 두 가지 게이트만을 활용하여,

불필요한 정보를 잘라내고 중요한 정보만을 전달한다.

업데이트 게이트는 과거 정보를 얼마나 유지할지 결정하고,

리셋 게이트는 과거 정보를 얼마나 무시할지를 결정하는 역할을 한다.

이러한 GRU의 구조는 계산의 효율성을 높이면서도, LSTM에 버금가는 뛰어난 성능을 보여준다.

따라서 시간과 자원이 제한적인 경우에도 효과적으로 사용될 수 있다.

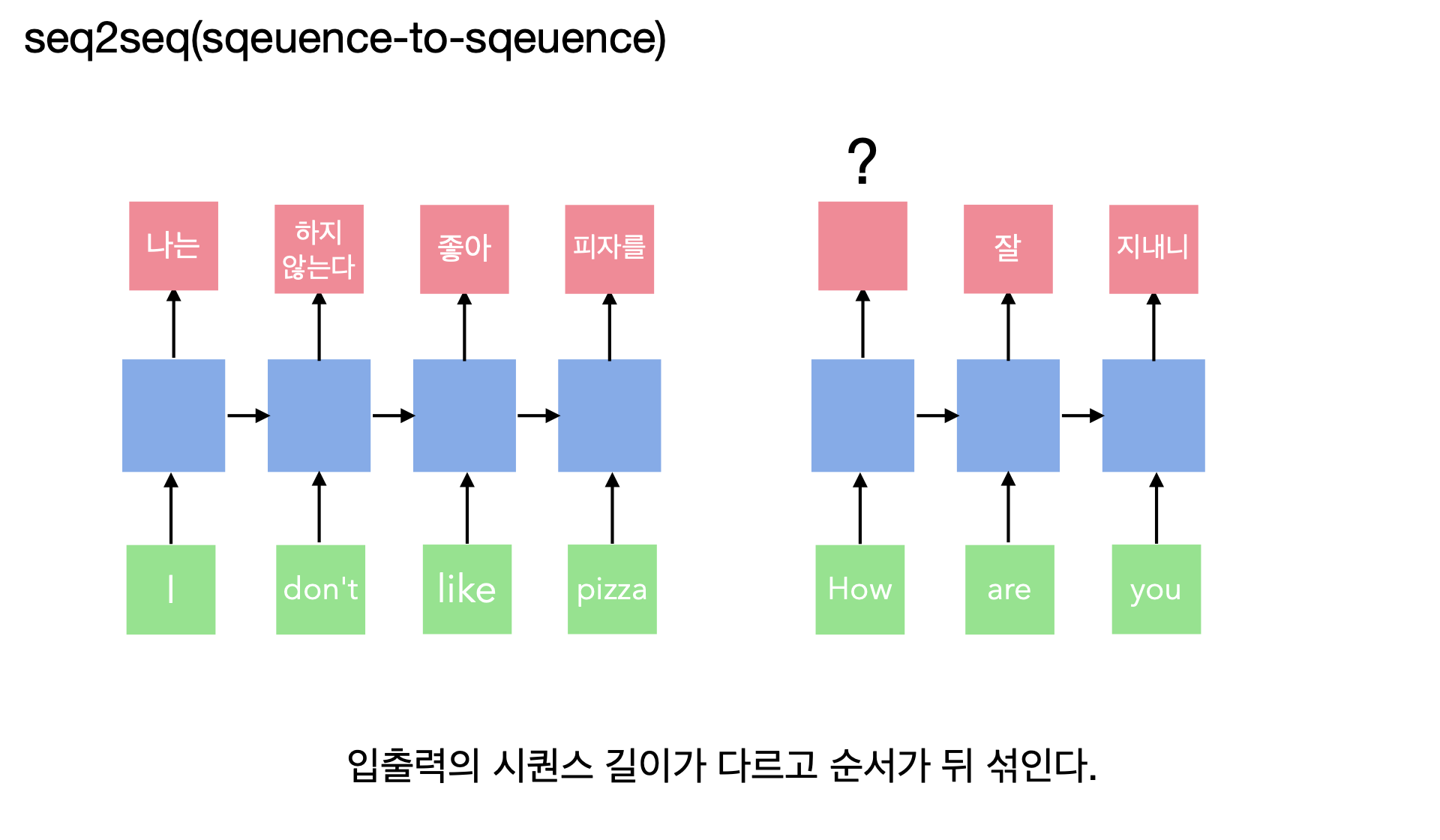

seq2seq: The Innovation

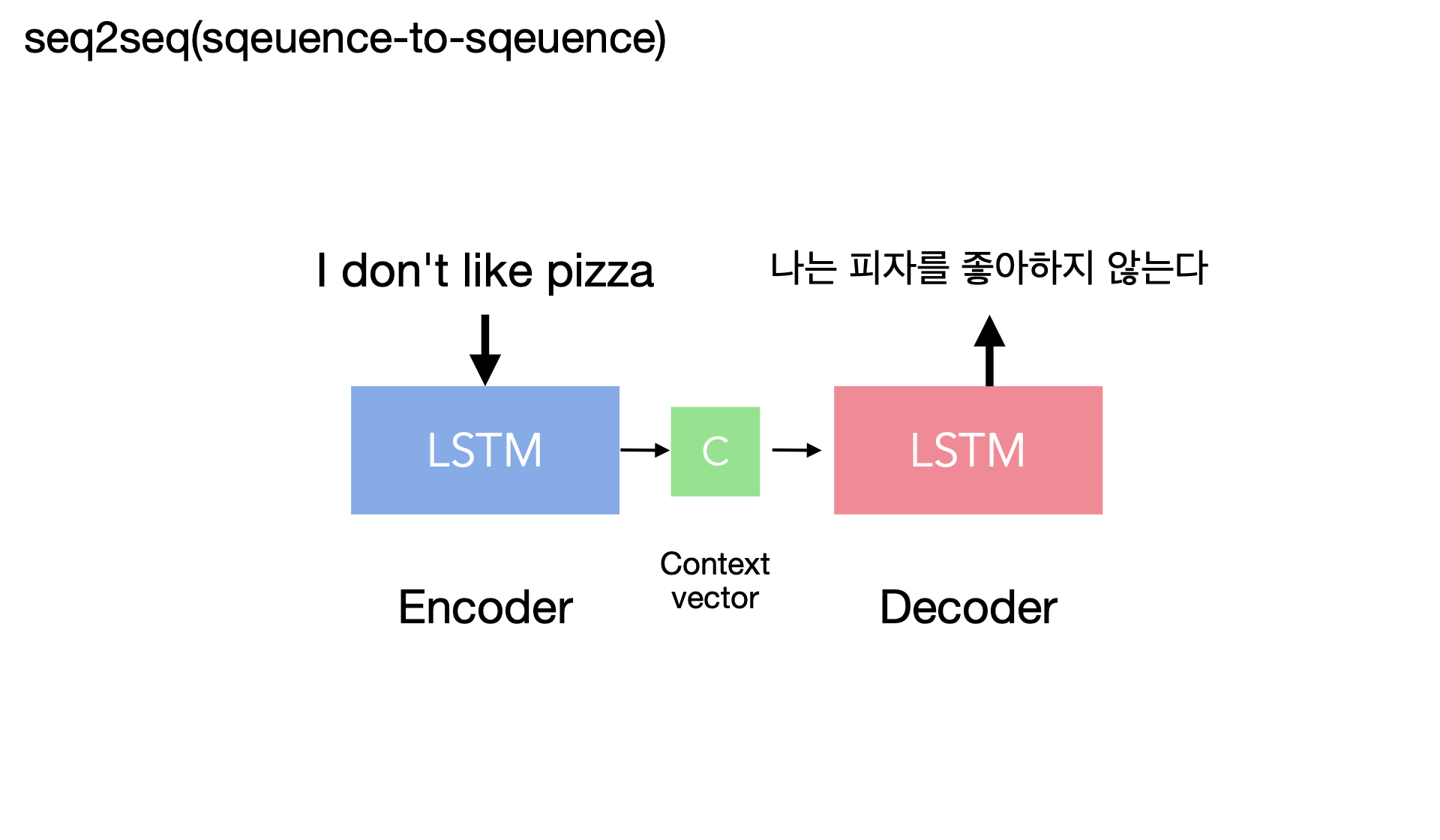

seq2seq 모델은 시퀀스 변환 작업에서 획기적인 역할을 한다.

인코더가 입력 시퀀스를 고정된 크기의 문맥 벡터로 압축하면, 디코더는 이를 통해 필요한 길이의 시퀀스로 확장한다.

이는 특히 기계 번역이나 자동 요약 같은 분야에서 큰 진전을 의미한다.

seq2seq 모델은 입력과 출력 시퀀스의 길이가 다르고, 심지어 순서가 뒤섞일 수 있는 문제에 탁월한 성능을 보여주지만,

이러한 유연성은 동시에 단점이 될 수 있다.

그 단점은 다음과 같은데, 문맥 벡터에 모든 정보를 압축해야 하므로 매우 긴 데이터에 대해서는 정보 손실의 위험이 있으며,

이로 인해 성능이 저하될 수 있다.

즉, 모든 시퀀스 정보를 하나의 벡터에 담아야 한다는 점에서 제한이 따른다.

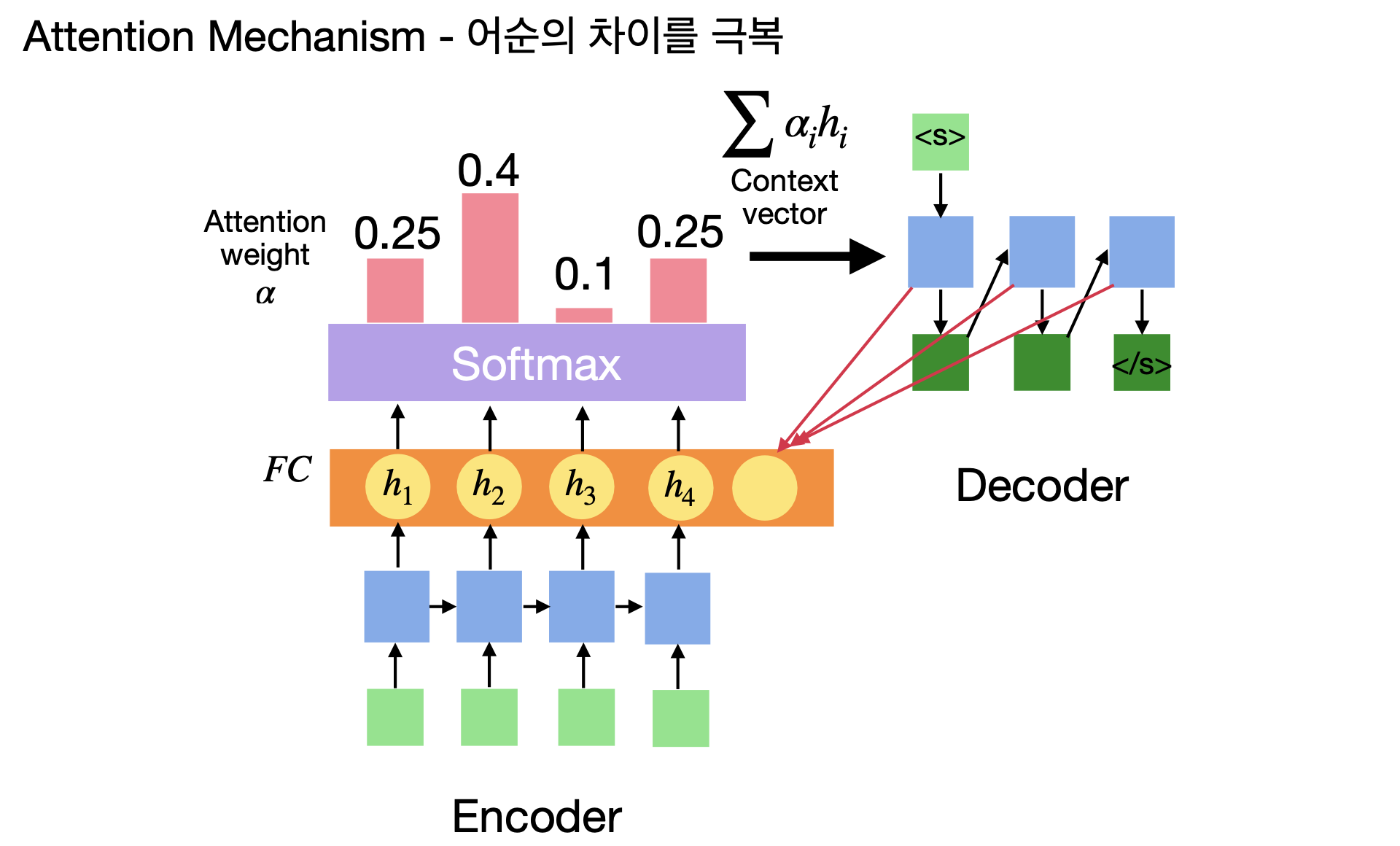

Attention Mechanism: The Evolution

어텐션 메커니즘은 순환 신경망의 중요한 진화다.

이 기술은 입력 시퀀스 내의 중요한 요소들에 집중하게 해 주며,

모델이 출력을 생성할 때 어떤 정보를 더 중시해야 할지 결정하도록 돕는다.

어텐션은 모델이 각 시퀀스 요소의 '중요도'를 가중치로 계산하며, 이 가중치는 최종 출력을 결정하는 데 사용된다.

이 방식은 특히 기계 번역과 같이 문맥 이해가 중요한 작업에서 모델의 성능을 크게 향상한다.

어텐션 메커니즘의 도입으로, 모델은 긴 시퀀스에서도 관련 정보를 효과적으로 포착하고,

각 단어나 구의 중요성을 이해하면서, 전체적인 문장 구조를 더 정확히 인식할 수 있게 되었다.

Beyond RNN: The Future

Transformer는 RNN이나 LSTM을 넘어서, 전체 시퀀스를 동시에 처리하는 혁신적인 구조다.

이 모델의 핵심은 '셀프 어텐션' 기능으로, 각 단어가 문장 내 다른 모든 단어와의 관계를 평가한다.

이는 기존 RNN이 시퀀스를 순차적으로 처리하는 것과 대비되어 훨씬 빠른 처리 속도를 가능하게 하며,

더 나은 문맥 이해를 제공한다.

Transformer의 등장은 순환 신경망의 미래를 새롭게 정의하며, 딥러닝 분야에 큰 발전을 가져왔다.

BERT: The Advancement

2019년, 언어 이해의 지평을 넓힌 BERT(Bidirectional Encoder Representations from Transformers)가 나타났다.

양방향 Transformer 기반으로 문맥을 양쪽에서 동시에 파악함으로써, 텍스트 안의 숨겨진 뉘앙스까지 포착한다.

이는 자연어 처리(NLP)에 혁명적 변화를 가져왔다.

문장 하나하나의 의미를 좌우 문맥 모두와 연계해 이해하는 BERT의 기술은 텍스트 분석의 정확성을 한 차원 끌어올렸다.

이것이 BERT가 주목받는 이유로, 기존 모델들을 뛰어넘는 성과를 보여주었다.

Conclusion

이처럼 순환 신경망은 시간의 흐름에 따라 정보를 전달하고,

시퀀스 데이터의 복잡한 패턴을 학습할 수 있는 강력한 도구다.

Vanilla RNN부터 시작하여 LSTM, GRU, seq2seq, 어텐션 메커니즘,

그리고 Transformer와 BERT에 이르기까지 순환 신경망의 발전은 머신러닝 분야에서 계속해서 새로운 혁신을 만들어내고 있다.

'ML+DL > Deep Learning' 카테고리의 다른 글

| 과적합과 그 방지법 (0) | 2024.04.11 |

|---|---|

| 생성적 적대 신경망(Generative Adversarial Network, GAN) (0) | 2024.04.11 |

| 오토 인코더(Autoencoder) (0) | 2024.04.11 |

| 순환 신경망(Recurrent Neural Network, RNN) (0) | 2024.04.09 |

| 합성곱 신경망(Convolutional Neural Network, CNN) (0) | 2024.04.07 |

| 합성곱 연산(Convolution) (0) | 2024.04.05 |

- Total

- Today

- Yesterday

- 백준

- 세계여행

- 자바

- 스트림

- 동적계획법

- BOJ

- 칼이사

- 남미

- 지지

- Python

- java

- 맛집

- 리스트

- spring

- 알고리즘

- 세모

- 유럽

- 기술면접

- 중남미

- 세계일주

- 유럽여행

- 여행

- RX100M5

- 파이썬

- 면접 준비

- 스프링

- Backjoon

- a6000

- Algorithm

- 야경

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |