티스토리 뷰

목차

활성화 함수(Activation Functions) 이해하기

손실 함수(Loss Functions)의 역할과 중요성

확률적 경사 하강법(Stochastic Gradient Descent, SGD)

합성곱 신경망(Convolutional Neural Network, CNN)

순환 신경망(Recurrent Neural Network, RNN)

순환 신경망의 발전(The Evolution of RNN)

Introduction

딥러닝의 세계는 복잡한 데이터로부터 학습할 수 있는 강력한 기계 학습 모델을 개발하는 것에 관한 것이다.

이 과정에서 모델이 데이터로부터 배우기 위해서는 '학습'이라는 과정이 필수적인데,

여기서 핵심적인 역할을 하는 것이 바로 '확률적 경사 하강법(Stochastic Gradient Descent, SGD)'이다.

이 게시글에서는 확률적 경사 하강법이 무엇인지, 다양한 최적화 방법과 그들의 장단점에 대해서 알아보고,

마지막으로 이러한 최적화 방법들이 어떻게 딥러닝 모델의 학습 과정을 개선하는지에 대한 이해를 간단히 다룬다.

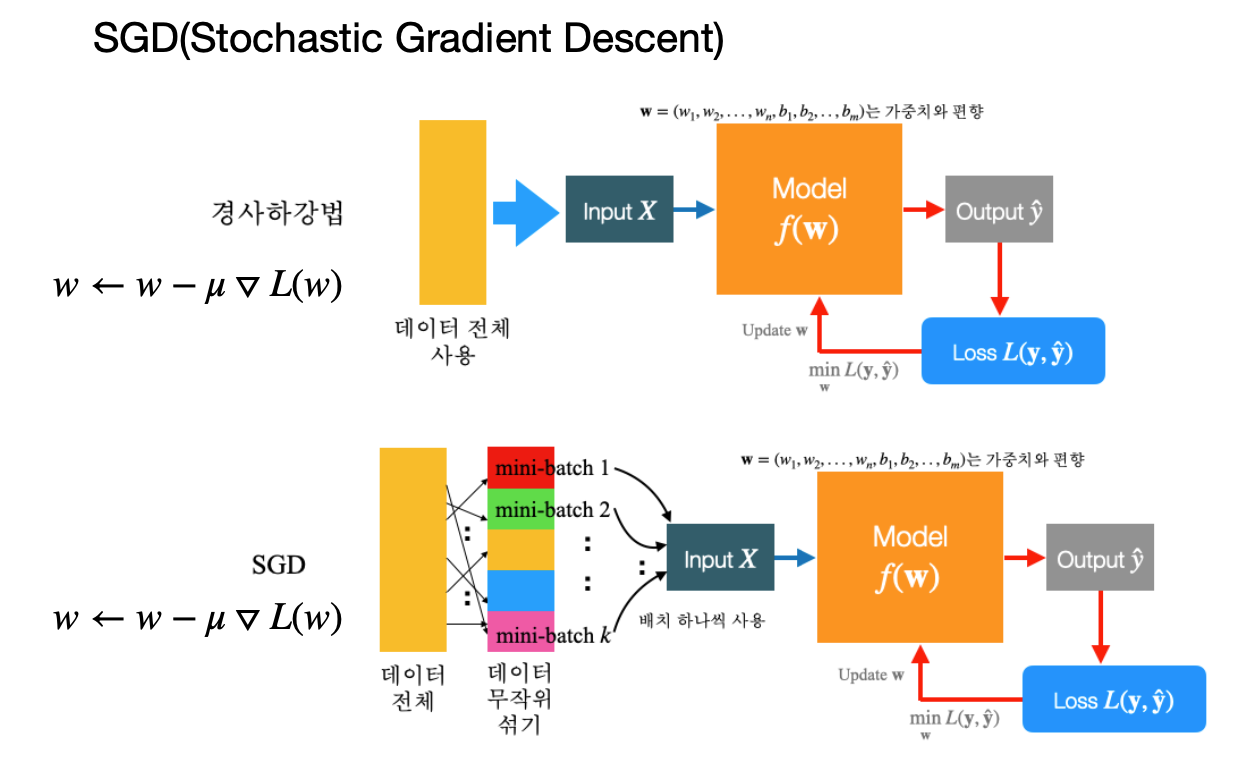

Stochastic Gradient Descent, SGD

확률적 경사 하강법은 머신러닝과 딥러닝에서 사용되는 가장 기본적인 최적화 기법 중 하나다.

이 방법의 핵심은 '경사 하강법(Gradient Descent)'에 있다.

경사 하강법은 함수의 기울기(경사)를 계산하여 함수의 최솟값을 찾아가는 방법이다.

즉, 모델의 오차를 나타내는 손실 함수(Loss Function)의 기울기를 계산하고,

이 기울기의 반대 방향으로 조금씩 움직여가면서 최소 손실 함숫값을 갖는 모델 파라미터를 찾아가는 과정이다.

그러나 실제 데이터셋은 매우 크고 복잡하기 때문에,

전체 데이터에 대해 한 번에 경사를 계산하는 것은 매우 비효율적이거나 불가능할 수 있다.

이 문제를 해결하기 위해 등장한 것이 '확률적' 경사 하강법이다.

이 방법은 전체 데이터셋에서 무작위로 선택한 일부 데이터만 사용해 경사를 계산한다.

이로 인해 계산 비용이 크게 줄어들고, 더 빠른 속도로 모델을 학습시킬 수 있다.

비록 무작위성으로 인해 경사의 추정이 부정확할 수 있지만,

이는 동시에 지역 최솟값(local minimum)에서 벗어날 수 있는 가능성을 제공하여 전반적인 최적화 과정에 도움을 준다.

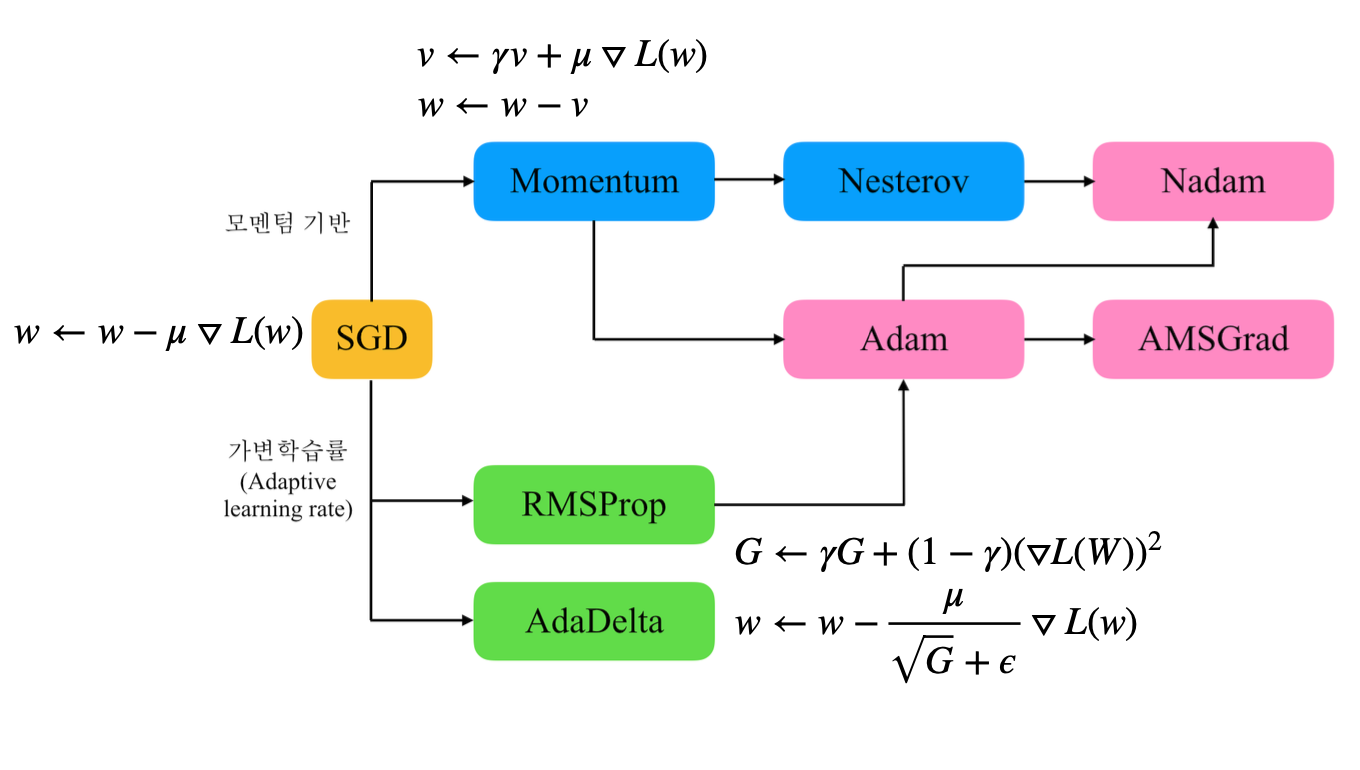

Optimization Methods

Momentum

모멘텀 방식은 공을 내리막길에 굴리는 것과 유사하다.

공이 가속되듯이 모델의 학습도 가속화한다.

즉, 이전 단계에서 계산된 경사의 방향과 크기를 기억하여, 현재의 경사와 합쳐서 파라미터를 업데이트한다.

이 방법은 SGD의 진동을 줄이고 더 빠르게 수렴하도록 도와준다.

RMSProp

RMSProp는 각 파라미터에 대해 학습 속도를 조정하여, 수렴 속도를 빠르게 한다.

이 방법은 가장 최근의 경사 이력만을 가지고 가중 평균을 내어, 학습률을 조절한다.

특히, 아주 가파른 방향으로는 학습률을 낮추며, 덜 가파른 방향으로는 학습률을 높여

전체적인 학습 과정이 더욱 효율적으로 이루어지게 한다.

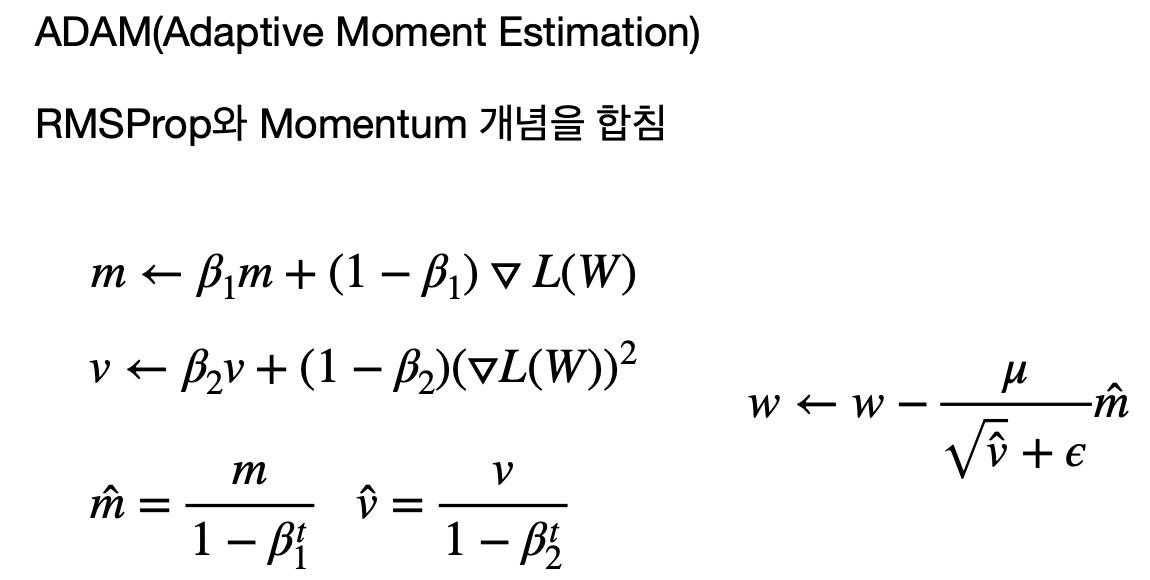

ADAM(Adaptive Moment Estimation)

ADAM은 RMSProp와 모멘텀 방식을 결합한 최적화 방법이다.

이 방법은 모멘텀처럼 과거의 기울기를 고려하면서, RMSProp처럼 각 파라미터에 대해 개별적인 학습률 조정을 한다.

ADAM은 빠른 수렴 속도와 높은 효율성 때문에 많은 연구자와 개발자들에게 선호되는 최적화 방법 중 하나다.

Learning Rate Scheduling

학습률(learning rate)은 모델 학습에 있어 가장 중요한 하이퍼파라미터 중 하나이다.

너무 크면 학습 과정에서 최솟값을 지나쳐 버릴 수 있고,

너무 작으면 학습이 너무 느려져서 실질적인 학습이 이루어지지 않을 수 있다.

이 문제를 해결하기 위해 도입된 것이 학습률 스케줄링이다.

이는 학습 과정 중에 학습률을 조절하는 방법이다.

예를 들어, StepLR은 일정한 주기로 학습률을 감소시키고,

ExponentialLR은 학습률을 지수적으로 감소시키며,

Cosine Annealing은 학습률을 코사인 함수의 형태로 조절한다.

이런 방법들은 모델이 더욱 안정적으로 최적점에 도달하도록 돕는다.

Conclusion

확률적 경사 하강법과 그 변형들은 딥러닝 모델을 효율적으로 훈련시키기 위한 핵심 도구들이다.

모델의 성능을 최대화하고, 학습 시간을 단축시키며, 자원 사용을 최적화하는 데 필수적이다.

모멘텀, RMSProp, ADAM, 학습률 스케줄링과 같은 다양한 최적화 방법들은 특정 문제에 더 적합한 해결책을 제공한다.

또한 학습률 스케줄링을 통해 안정적인 학습을 유도할 수 있기 때문에 이와 같은 개념들은 딥러닝 이해에 필수적이라 할 수 있겠다.

'ML+DL > Deep Learning' 카테고리의 다른 글

| 컴퓨터 비전(Computer Vision) (0) | 2024.04.04 |

|---|---|

| 손실 함수와 최적화 (0) | 2024.04.04 |

| 기울기 사라짐(Vanishing Gradient) (0) | 2024.04.04 |

| 딥러닝에서의 최적화: 하강법과 경사하강법 (0) | 2024.03.27 |

| 손실 함수(Loss Functions)의 역할과 중요성 (0) | 2024.03.21 |

| 활성화 함수(Activation Functions) 이해하기 (0) | 2024.03.12 |

- Total

- Today

- Yesterday

- 중남미

- RX100M5

- 자바

- 스프링

- 스트림

- 칼이사

- 유럽

- 남미

- Python

- 동적계획법

- BOJ

- 여행

- Algorithm

- 세계여행

- 기술면접

- 리스트

- 세계일주

- 파이썬

- spring

- 알고리즘

- 세모

- 지지

- 야경

- Backjoon

- java

- 맛집

- 유럽여행

- a6000

- 백준

- 면접 준비

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |