티스토리 뷰

활성화 함수(Activation Functions) 이해하기

손실 함수(Loss Functions)의 역할과 중요성

확률적 경사 하강법(Stochastic Gradient Descent, SGD)

합성곱 신경망(Convolutional Neural Network, CNN)

순환 신경망(Recurrent Neural Network, RNN)

순환 신경망의 발전(The Evolution of RNN)

Introduction

딥러닝 알고리즘에서 가장 중요한 개념 중 하나는 '기울기 사라짐'이다.

이 현상은 신경망을 학습시키는 과정에서 발생하며, 학습의 효율성을 크게 저하시킨다.

이 게시글에서는 기울기 사라짐이 무엇인지, 왜 발생하는지를 간결하게 설명하고,

이를 완화시키기 위한 방법으로서의 ReLU 함수에 대해 다룬다.

Vanishing Gradient

딥러닝에서의 학습 과정은 가중치(weight)를 조정하는 것에서 시작된다.

이 과정에서 연쇄 법칙(chain rule)은 굉장히 중요한 역할을 한다.

연쇄 법칙은 한 함수의 결과가 다른 함수의 입력으로 연결될 때,

전체 합성 함수의 미분을 개별 함수의 미분으로 분해할 수 있게 해 준다.

즉, 출력값에 대한 가중치의 미분값을 구하기 위해 중간의 각 활성화 함수의 미분값들을 곱하는 것이다.

기울기 사라짐은 특히 깊은 신경망에서 나타나는 현상으로,

네트워크의 뒷부분에서 계산된 기울기가 앞부분으로 전파될 때 점점 작아져서,

앞쪽 층의 가중치가 실질적으로 업데이트되지 않는 문제를 말한다.

이는 신경망이 깊어질수록, 즉 층(layer)이 많아질수록 더욱 심각해진다.

신경망의 각 층을 거칠 때마다 기울기는 활성화 함수의 도함수(derivative)에 의해 영향을 받는데,

Sigmoid와 같은 일부 함수는 출력 범위가 제한적이고 도함수 값이 매우 작아, 기울기가 소실되는 문제가 발생한다.

Sigmoid Function

Sigmoid 함수의 미분값은 σ(x)(1−σ(x))로 표현되며, 이 값은 x가 크거나 작을 때 매우 작아진다.

따라서 역전파 시에 이 작은 값들이 곱해지면서, 오차 신호가 점점 약해져 초기 층에 도달할 때 거의 사라진다.

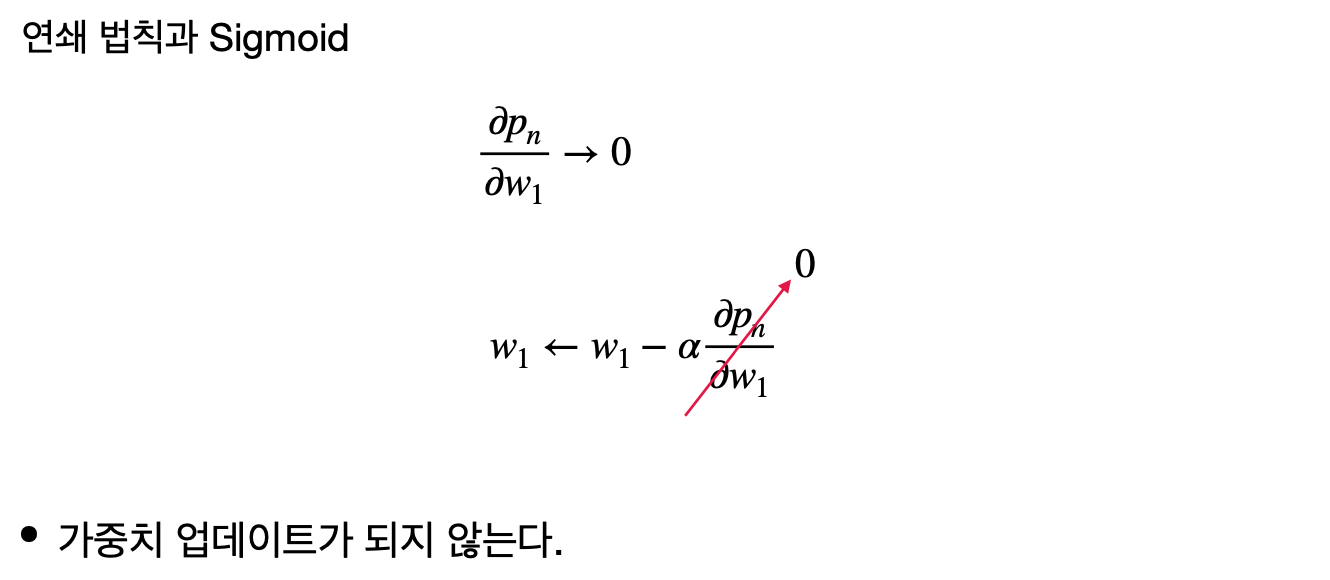

이는 초기 층의 가중치들이 거의 업데이트되지 않음을 의미한다. 이 현상은 \partial _P_n / \partial_w_1 이

0에 가까워짐으로써 발생하고, 결국 가중치 업데이트가 되지 않는다.

ReLU

이러한 문제를 해결하기 위해 등장한 것이 ReLU(Rectified Linear Unit) 함수이다. ReLU는 a(x)=max(0,x)로 정의되며,

음수 입력에 대해서는 0을 출력하고, 양수 입력에 대해서는 입력값을 그대로 출력한다.

ReLU의 미분은 음수 입력에 대해서는 0이고, 양수 입력에 대해서는 1이다.

이 특징은 역전파 과정에서 기울기가 사라지는 문제를 크게 완화시킨다.

Leaky ReLU는 ReLU의 변형으로, 음수 입력에 대해서도 매우 작은 기울기를 허용한다.

이를 통해, ReLU가 가지는 '죽은 뉴런(dead neuron)' 문제, 즉, 항상 0을 출력하는 뉴런을 해결한다.

Conclusion

기울기 사라짐은 신경망이 깊어질수록 문제가 심각해지는 경향이 있다.

이를 해결하기 위한 여러 가지 전략이 있으며, 각각의 방법은 문제를 완화하는 데 기여할 수 있다.

가장 중요한 것은 신경망의 특성과 학습 데이터에 가장 적합한 방법을 선택하는 것이다.

이를 통해 신경망의 성능을 향상하고, 더 빠르고 효율적으로 학습을 진행할 수 있다.

'ML+DL > Deep Learning' 카테고리의 다른 글

| 합성곱 연산(Convolution) (0) | 2024.04.05 |

|---|---|

| 컴퓨터 비전(Computer Vision) (0) | 2024.04.04 |

| 손실 함수와 최적화 (0) | 2024.04.04 |

| 확률적 경사 하강법(Stochastic Gradient Descent, SGD) (0) | 2024.04.02 |

| 딥러닝에서의 최적화: 하강법과 경사하강법 (0) | 2024.03.27 |

| 손실 함수(Loss Functions)의 역할과 중요성 (0) | 2024.03.21 |

- Total

- Today

- Yesterday

- 유럽여행

- 리스트

- 중남미

- 면접 준비

- 맛집

- 세모

- Backjoon

- 동적계획법

- spring

- java

- Algorithm

- 백준

- 여행

- 세계여행

- 유럽

- 칼이사

- 남미

- 지지

- 야경

- a6000

- 스트림

- 스프링

- Python

- 기술면접

- 파이썬

- 자바

- RX100M5

- BOJ

- 알고리즘

- 세계일주

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |