티스토리 뷰

목차

이번엔 백본(Backbone)이다. 공부하면서 좀 더 알아야 할 것 같은 개념을

나를 위해 정리하는 글이기 때문에 너무 쉬울 수도 있다.

일단 백본이 뭔지 다시는 검색하지 않기 위해 정리한다.

시작!

1. 백본(Backbone)이란?

비전 인공지능, 특히 객체 탐지(Object Detection), 이미지 분류(Image Classification),

세그멘테이션(Segmentation) 같은 작업에서 자주 듣게 되는 용어가 있다.

바로 백본(Backbone)이다.

백본은 신경망(Neural Network)에서 입력 이미지가 처음 들어와서 지나가는 부분,

즉, 초기 단계에서 특징(Feature)을 뽑아주는 역할을 하는 기본 구조를 의미한다.

쉽게 말하면, 이미지에서 중요한 정보를 걸러내는 기초 근육 같은 존재다.

이미지는 수많은 픽셀(pixel)로 이루어져 있다.

예를 들어, 224x224 크기의 컬러 이미지가 있다면, 224 x 224 x 3(RGB), 즉 약 15만 개의 숫자(픽셀 값)가 존재한다.

이 숫자들만 보고 “이게 강아지인지, 고양이인지” 판단하는 것은 사람도 어렵고, 컴퓨터도 마찬가지다.

백본은 이 수많은 숫자들(픽셀 정보)에서 핵심적인 특징(Feature)을 뽑아내는 역할을 한다.

예를 들어, 강아지를 판단할 때 강아지의 귀 모양, 눈 위치, 전체적인 얼굴 패턴 같은 것들이 핵심 정보다.

백본은 이런 시각적 특징들을 찾아서 뒷단에 넘겨주는 과정을 담당한다.

객체 탐지(Object Detection)란?

이미지 속에서 특정 객체(예: 사람, 자동차, 강아지 등)의 위치와 종류를 찾아내는 기술이다.

“이 부분이 사람이고, 저 부분이 자동차다”라고 좌표와 함께 알려주는 것이다.

결과는 보통 사각형 박스(Bounding Box)로 나타난다.

이미지 분류(Image Classification)란?

이미지가 무엇인지 하나로 분류하는 작업이다.

“이 이미지는 강아지다”, “이 이미지는 고양이다”처럼 이미지 전체에 대한 하나의 레이블(label)을 부여하는 것이다.

세그멘테이션(Segmentation)이란?

이미지에서 각 픽셀이 어떤 객체에 속하는지를 구분하는 작업이다.

“이 픽셀은 강아지의 귀다, 저 픽셀은 강아지의 몸이다” 이런 식으로

픽셀 단위로 어떤 객체에 속하는지 색칠하듯 표시하는 기술이다.

즉, 객체 탐지, 이미지 분류, 세그멘테이션 모두 이미지를 보고 판단하는 비전 인공지능 작업인데,

이 모든 작업의 출발점이 바로 백본(Backbone)이다.

백본이 이미지에서 의미 있는 특징을 잘 뽑아줘야 뒷단에서도 정확하게 탐지하고 분류할 수 있다.

2. 비유로 이해하기: 사람 눈과 뇌의 역할

사람이 고양이를 본다고 가정해 보자.

집 거실에 앉아 있는데 멀리서 고양이가 다가오고 있다.

사람은 자연스럽게 눈으로 고양이를 바라본다.

이때 눈은 고양이의 형태, 색깔, 움직임 같은 시각적 정보를 받아들인다.

그런데 눈이 고양이라는 사실을 인식하는 것일까?

그렇지 않다.

눈은 단순히 시각 정보를 수집하는 센서 역할을 할 뿐이다.

이 정보를 신경을 통해 뇌로 전달하는 과정이 뒤따른다.

이제 뇌가 정보를 받아 분석한다.

뇌는 다음과 같이 판단한다.

- “둥근 머리, 뾰족한 귀, 네 발로 걷는 동물이다.”

- “예전에 본 적 있는 고양이와 비슷하다.”

- “이건 고양이다.”

이렇게 사람은 눈 → 신경 → 뇌를 거쳐 고양이라는 결론을 내린다.

이 과정을 인공지능 모델에 대입하면,

백본(Backbone)은 눈에 해당하고,

탐지기(Detector)는 뇌에 해당한다.

백본은 이미지에서 가장 중요한 시각적 특징(윤곽, 색상, 형태 등)을 뽑아내는 단계이다.

고양이를 인식하려면 고양이의 귀, 눈, 몸통 모양, 털색 같은 특징을 뽑아야 한다.

백본이 이 역할을 한다.

백본이 튼튼하면(성능이 좋으면) 뇌(탐지기)가 쉽게 판단할 수 있다.

“아, 귀도 보이고, 눈도 보이고, 털색도 선명하네. 이건 고양이야!”

하지만 백본이 부실하면(성능이 나쁘면) 뇌가 애를 먹는다.

“이게 귀인지 그림자인지 잘 모르겠고, 털색도 흐릿한데… 고양이 같기도 하고 아니기도 하고…”

결국 눈(백본)이 잘 보여야 뇌(탐지기)가 잘 판단한다.

좋은 백본이 좋은 탐지 성능으로 이어지는 이유가 바로 이것이다.

3. 백본의 실제 역할

딥러닝 모델에서 이미지는 숫자로 이루어진 픽셀(pixel) 덩어리일 뿐이다.

사람 눈에는 강아지나 고양이처럼 보일지 몰라도, 컴퓨터는 0부터 255까지의 숫자 배열로만 인식한다.

예를 들어, 224 x 224 크기의 컬러 이미지가 입력되었다고 하자.

이 이미지는 컴퓨터 입장에서 224 x 224 x 3(RGB) 크기의 숫자 행렬이다.

- 224는 가로 픽셀 수

- 224는 세로 픽셀 수

- 3은 빨강(R), 초록(G), 파랑(B)의 색상 채널

즉, 224 x 224 x 3 = 총 150,528개의 숫자가 있는 셈이다.

이 숫자들은 각각의 픽셀이 얼마나 빨갛고, 초록이고, 파란지를 표현한다.

왜 그냥 보면 안 될까?

이 숫자 배열을 그대로 보고 고양이인지 강아지인지 구분하는 건 너무 어렵다.

사람도 사진을 엄청 확대해서 픽셀만 보라고 하면 알아보기 어렵다.

컴퓨터도 마찬가지다.

그래서 백본(Backbone)이 필요한 것이다.

백본은 이 숫자들 속에서 의미 있는 특징(feature)을 뽑아준다.

특징이란 무엇일까?

- 이 부분은 경계선 같다.

- 이 부분은 둥글게 생겼다.

- 이 부분은 눈 모양처럼 생겼다.

이런 것들을 찾아주는 것이다.

백본의 핵심 기능

백본은 이런 특징을 뽑는 대표적인 3가지 기능을 한다.

- 엣지(edge) 찾기:

→ 밝기 차이가 큰 부분을 찾아서 물체의 경계선을 감지한다.

예를 들어, 고양이 얼굴과 배경 사이의 경계, 귀와 얼굴의 경계 같은 부분이다.

사람도 그림 그릴 때 윤곽선부터 따듯이, 컴퓨터도 경계선을 먼저 찾아야 한다. - 코너(corner) 감지:

→ 선이 꺾이는 부분, 즉 모서리 부분을 찾아낸다.

예를 들어, 강아지 귀 끝, 눈 가장자리, 입 주변 모서리 같은 부분이다.

사람도 물건을 구분할 때 눈, 코, 입의 위치를 보고 판단하듯이,

컴퓨터도 모서리 같은 특징적인 부분을 중점적으로 본다. - 패턴(pattern) 인식:

→ 특정 모양이나 질감(패턴)을 찾는다.

예를 들어, 고양이 털 무늬, 귀의 삼각형 모양, 사람의 눈 모양 같은 것들이다.

이런 패턴들이 모이면 ‘고양이 같다’, ‘사람 같다’고 판단할 수 있다.

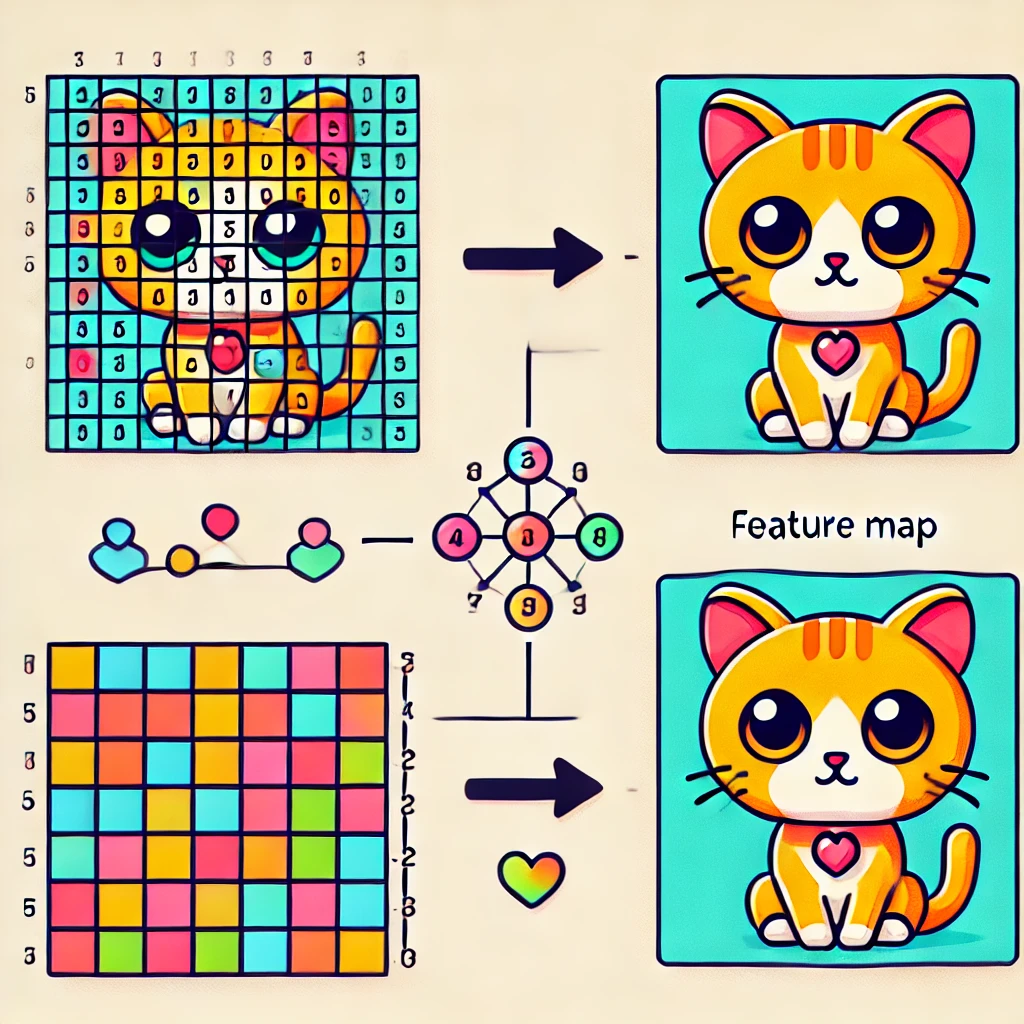

특징을 뽑고 나면?

백본이 이런 특징들을 뽑아내면,

원래는 224 x 224 x 3짜리 숫자 덩어리였던 이미지가

이제는 작고 중요한 정보만 담긴 특징맵(Feature Map)이 된다.

Feature Map(특징 맵)은 다음과 같다.

- 원본 이미지보다 크기가 작다.

- 강아지 귀 위치, 눈 위치, 경계선 정보 같은 중요한 내용이 요약되어 있다.

- 사람이 사진을 보고 "고양이인 것 같아"라고 직관적으로 판단하는 것처럼

백본이 "이 부분이 고양이 특징이다"라고 뽑아낸 것이다.

이 특징 맵이 뒷단(Detector)으로 넘어가서

“이건 고양이다”, “이건 강아지다”라는 최종 판단으로 이어지는 것이다.

결국, 백본이 좋은 특징을 뽑아내느냐가 인공지능 모델의 성능을 결정하는 핵심이다.

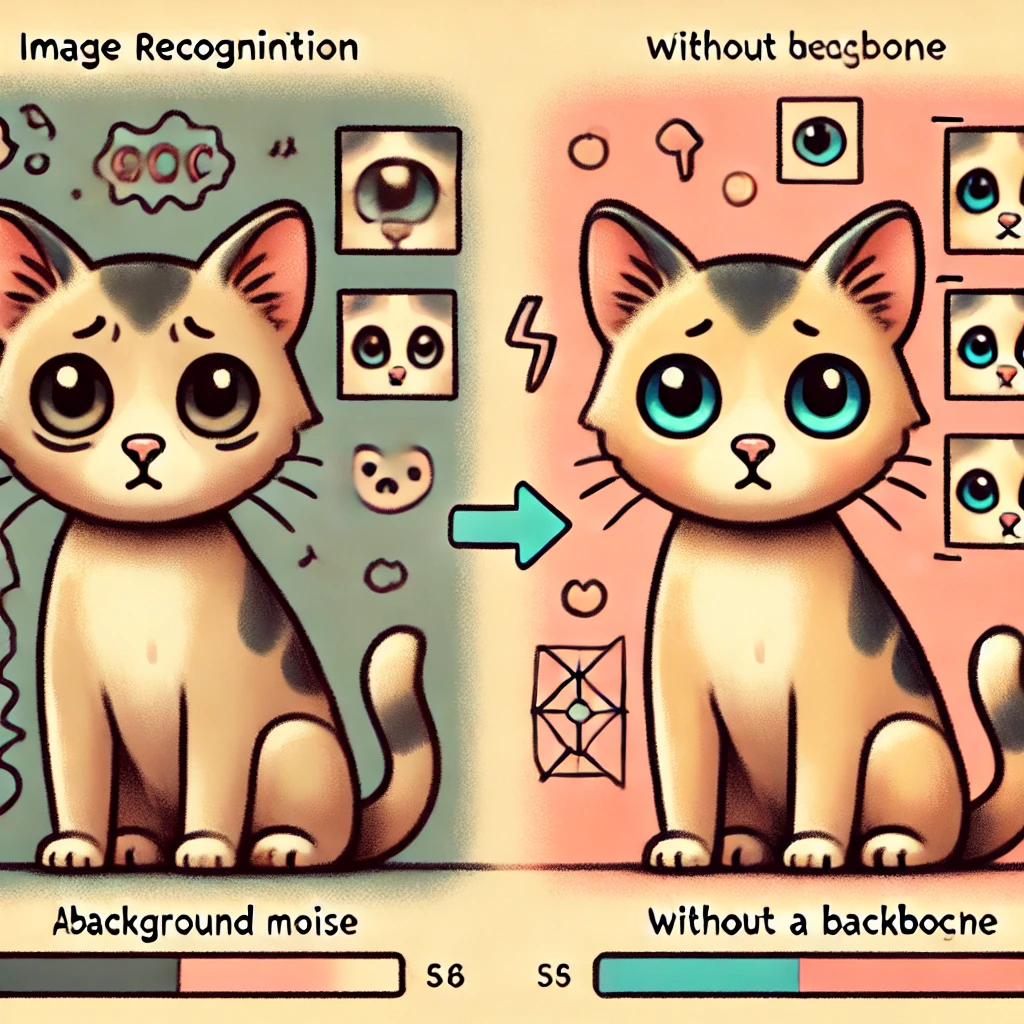

4. 백본이 없는 경우 vs 있는 경우 비교

비전 인공지능에서 백본(Backbone)의 유무는 모델의 인식 과정과 성능에 큰 영향을 미친다.

백본이 없는 경우와 있는 경우를 비교하면 데이터를 어떻게 처리하느냐의 차이를 명확하게 이해할 수 있다.

백본이 없는 경우: 원본 이미지 그대로 분석

백본이 없다는 것은 이미지에서 특징을 추출하는 과정 없이, 원본 데이터를 그대로 사용한다는 의미이다.

쉽게 말해, 이미지를 직접 보고 “이게 고양이다!”라고 판단하는 것과 비슷하다.

예를 들어, 사람이 고양이를 보고 인식하는 과정을 생각해 보자.

개를 처음 보는 어린아이는 전체적인 형태를 보고 “이건 고양이야”라고 바로 인식하지 못할 수도 있다.

왜냐하면 고양이는 다양한 색상, 크기, 품종을 가지고 있고, 배경과 섞여 있을 가능성이 크기 때문이다.

AI 모델도 마찬가지다.

백본 없이 원본 이미지(픽셀 값)를 그대로 입력하면, 모델이 중요한 특징을 뽑아내지 못하고 혼란스러워질 가능성이 크다.

예시:

- 고양이 사진과 여우 사진이 주어졌을 때, 단순히 색상이나 크기 차이만 보고 판단하려 하면 구분이 어려울 것이다.

- 같은 고양이라도 배경이 바뀌거나, 일부가 가려져 있으면 모델이 고양이를 인식하지 못하거나 잘못된 판단을 내릴 수 있다.

결국 백본이 없으면 모델이 이미지의 구조적인 정보를 이해하지 못하고, 단순히 픽셀 값만 보고 판단하려고 하게 된다.

이렇게 되면 복잡한 장면에서는 제대로 구분하기 어렵다.

백본이 있는 경우: 중요한 특징을 추출하여 분석

백본이 있는 경우, 모델은 이미지를 단순히 픽셀 덩어리로 보는 것이 아니라, 의미 있는 패턴과 구조를 분석할 수 있다.

즉, 원본 이미지에서 중요한 특징(feature)을 뽑아내어 뒷단(객체 탐지, 분류 등)에 넘겨주는 역할을 한다.

이 과정은 사람이 고양이를 인식하는 방식과 유사하다.

우리는 고양이를 볼 때, 고양이의 눈, 귀, 코의 위치, 털의 패턴, 몸의 형태 등을 종합적으로 분석한다.

비슷한 방식으로, 백본은 고양이의 귀 모양, 몸통 패턴, 꼬리 위치 등 특징적인 요소들을 학습하여 뽑아낸다.

예시:

- 고양이와 여우가 비슷하게 생겼어도, 백본이 있는 모델은 귀 모양, 털 패턴, 눈의 크기와 위치 등 결정적인 차이를 분석할 수 있다.

- 배경이 바뀌어도, 고양이의 형태와 구조적인 특징을 학습한 모델은 배경과 관계없이 고양이를 인식할 수 있다.

핵심 개념: 특징 맵(Feature Map)

백본이 뽑아낸 특징들은 Feature Map(특징 맵)이라는 형태로 변환된다.

특징 맵이란 이미지에서 추출된 중요한 정보들이 압축된 데이터라고 보면 된다.

이를 통해, 모델의 뒷단에서는 더 효율적으로 이미지를 해석하고 객체를 인식할 수 있게 된다.

백본이 없는 경우 vs 있는 경우 비교 정리

| 구분 | 백본이 없는 경우 | 백본이 있는 경우 |

| 특징 | 원본 이미지(픽셀)를 그대로 분석 | 이미지에서 중요한 특징(Feature)을 추출 |

| 분석 방식 | 전체적인 형태를 그대로 보고 판단 | 엣지, 패턴, 모양 등 특징을 분해하여 분석 |

| 문제점 | 배경이 바뀌거나 일부 가려지면 오인식 가능 | 배경과 무관하게 의미 있는 특징만 추출 가능 |

| 예시 | 개와 늑대를 색상, 크기로만 구분 | 개와 늑대를 귀 모양, 털 패턴, 눈 위치로 구분 |

| 결과 | 복잡한 장면에서 잘못된 판단 가능 | 다양한 환경에서도 안정적인 인식 가능 |

결론적으로, 백본이 없는 모델은 이미지의 표면적인 정보에 의존하는 반면,

백본이 있는 모델은 의미 있는 패턴과 구조를 학습하여 더욱 정교한 분석을 수행할 수 있다.

따라서, 객체 탐지나 이미지 분류 모델에서는 백본이 필수적이며, 어떤 백본을 사용하는지가 모델의 성능을 결정짓는 중요한 요소가 된다.

5. 유명한 백본(Backbone) 종류

앞서 계속해서 강조했듯, 객체 탐지나 이미지 분류에서 백본은 성능을 좌우하는 중요한 요소다.

다양한 백본 모델이 존재하며, 각각의 구조와 특징이 다르다.

백본을 선택할 때는 속도, 정확도, 연산량을 고려해야 한다.

아래에서 대표적인 백본들을 살펴보자.

VGG (Visual Geometry Group Network)

VGG는 2014년 옥스퍼드 대학교 VGG 팀에서 발표한 CNN 기반 백본이다.

이전까지 쓰이던 모델들보다 더 깊은 층을 쌓아서 성능을 높인 것이 특징이다.

구조적인 특징

- VGG16과 VGG19가 대표적이며, 각각 16개, 19개의 층을 가진다.

- 네트워크가 깊어질수록 더 많은 패턴을 학습할 수 있다.

- 3x3 합성곱 필터만 사용하여 단순한 구조를 유지했다.

장점

- 구조가 단순해서 이해하기 쉽고 구현하기 편리하다.

- 작은 크기의 3x3 필터를 여러 개 쌓아도 큰 필터(5x5, 7x7)와 비슷한 효과를 낼 수 있다.

- 여러 연구에서 백본으로 자주 사용되며, 지금도 많이 참고된다.

단점

- 너무 깊어서 파라미터 수가 많고 연산량이 크다.

- 네트워크가 깊어지면 학습 속도가 느리고, 메모리도 많이 차지한다.

- 기울기 소실(Vanishing Gradient) 문제가 발생하기 쉽다.

사용처

VGG는 입문자들이 백본 개념을 익히기에 좋고, 논문에서도 비교 기준으로 많이 사용된다.

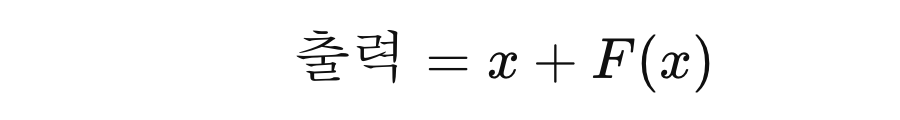

ResNet (Residual Network)

ResNet은 2015년 마이크로소프트(Microsoft)에서 개발한 백본이다.

딥러닝 네트워크가 깊어지면 생기는 기울기 소실(Vanishing Gradient) 문제를 해결하기 위해

잔차 연결(Skip Connection) 개념을 도입했다.

구조적인 특징

- 잔차 블록(Residual Block)을 사용하여 입력 데이터를 그대로 다음 층으로 전달한다.

- 이전 층의 출력 x를 그대로 다음 층과 더해주는 방식이다.

- 덕분에 층이 깊어져도 학습이 원활하게 진행된다.

- ResNet-18, ResNet-34, ResNet-50, ResNet-101, ResNet-152 등 다양한 크기의 모델이 존재한다.

장점

- 매우 깊은 네트워크(100층 이상)도 학습 가능하다.

- VGG보다 연산량이 적고, 성능이 더 뛰어나다.

- 객체 탐지, 이미지 분류 등 다양한 비전 모델에서 기본 백본으로 많이 사용된다.

단점

- 구조가 복잡해서 초보자들이 이해하기 어렵다.

- 작은 네트워크에서는 잔차 연결이 큰 이점이 없다.

- 너무 깊은 모델(ResNet-152)은 메모리를 많이 사용한다.

사용처

현재 가장 널리 사용되는 백본 중 하나로, Faster R-CNN, YOLO 등 다양한 객체 탐지 모델에서도 ResNet을 백본으로 활용한다.

MobileNet

MobileNet은 구글에서 개발한 경량화 백본이다.

이름에서 알 수 있듯이, 모바일 및 임베디드 환경에서도 원활히 동작할 수 있도록 설계되었다.

모델이 가벼워야 하므로, 계산량을 줄이면서도 성능을 유지하는 방법이 중요하다.

구조적인 특징

- Depthwise Separable Convolution(깊이별 분리 합성곱)을 사용하여 연산량을 대폭 줄였다.

- 기존 CNN은 필터 하나가 모든 채널을 다 보지만, MobileNet은 채널별로 따로 연산하는 방식이다.

- 이를 통해 기존 CNN 대비 8~9배 적은 연산량을 갖는다.

장점

- 속도가 빠르고, 모델이 가볍다. (모바일에서도 사용 가능)

- 메모리 사용량이 적어 작은 디바이스에서도 동작할 수 있다.

- 다양한 변형 모델(MobileNetV2, MobileNetV3 등)도 개발되어 최적화 가능하다.

단점

- ResNet 같은 대형 백본보다 정확도가 다소 떨어진다.

- 작은 모델이므로, 복잡한 객체 탐지에는 한계가 있다.

- 작은 크기의 합성곱 필터를 사용하기 때문에 세밀한 특징을 잡기 어렵다.

사용처

실시간 객체 탐지(예: 모바일 앱), 경량화 모델이 필요한 곳에서 사용된다.

EfficientNet

EfficientNet은 2019년 구글에서 발표한 최신 백본으로,

적은 연산량으로도 높은 성능을 내는 효율적인 네트워크다.

기존 모델들은 크기를 키우거나 깊이를 늘리는 방식이었지만,

EfficientNet은 스케일링 법칙(Compound Scaling)을 적용하여 균형 잡힌 확장을 했다.

구조적인 특징

- Depth(깊이), Width(너비), Resolution(해상도) 조합을 최적화했다.

- 기존 모델들은 크기를 무작정 키웠지만, EfficientNet은 균형 있게 키운다.

- EfficientNet-B0 ~ B7까지 다양한 크기의 모델이 존재한다.

- B0: 가벼운 모델

- B7: 가장 강력한 모델 (대신 연산량 많음)

장점

- 기존 백본보다 성능이 높고, 연산량은 적다.

- 같은 정확도를 내면서도 더 적은 연산을 필요로 한다.

- 다양한 변형 모델이 존재하여 어떤 환경에서도 적용 가능하다.

단점

- 모델이 상대적으로 최신이어서 최적화된 라이브러리가 적다.

- ResNet처럼 오랜 기간 검증된 모델이 아니라 일부 환경에서 안정성이 부족할 수 있다.

사용처

높은 성능과 효율성이 동시에 필요한 모델에서 사용된다.

현재 객체 탐지, 이미지 분류, 세그멘테이션에서 ResNet을 대체할 가능성이 있는 모델로 평가받고 있다.

6. 객체 탐지 모델에서의 백본 역할

객체 탐지(Object Detection) 모델에서는 백본이 매우 중요한 역할을 한다.

객체 탐지는 단순한 이미지 분류(Classification)와 달리,

이미지 속 여러 객체를 정확한 위치에 박스로 표시해야 하는 복잡한 작업이다.

이 과정에서 백본은 이미지에서 중요한 특징(Feature)을 뽑아주는 역할을 담당한다.

즉, 백본이 얼마나 좋은 특징을 뽑아내느냐에 따라 탐지 모델의 성능이 크게 좌우된다.

객체 탐지 모델의 기본 흐름

객체 탐지 모델은 크게 세 단계로 구성된다.

- 이미지를 입력받는다.

- 입력 이미지는 일반적으로 224x224 또는 416x416 같은 정해진 크기로 변환된다.

- 컬러 이미지는 보통 3채널(RGB)로 들어간다.

- 백본이 특징을 추출한다.

- 이미지에서 윤곽선, 패턴, 텍스처 같은 저수준(low-level) 특징을 추출한다.

- 이후 점점 더 복잡한 구조(눈, 코, 귀 등)를 뽑아내는 고수준(high-level) 특징을 학습한다.

- 이 과정에서 다중 합성곱 연산(Convolution)과 풀링(Pooling) 연산이 적용된다.

- 탐지 헤드(Detection Head)가 위치와 클래스를 예측한다.

- 백본이 만든 특징을 바탕으로 각 객체의 위치(Bounding Box)와 클래스(강아지, 고양이 등)를 예측한다.

- 예측된 박스들 중에서 중복된 것들을 제거하는 NMS(Non-Maximum Suppression) 과정이 적용된다.

이처럼 객체 탐지 모델의 핵심은 백본이 얼마나 좋은 특징을 뽑아주는가에 달려 있다.

같은 탐지 모델이라도 백본을 어떤 것을 사용하느냐에 따라 속도와 정확도가 달라질 수 있다.

백본에 따른 객체 탐지 모델의 성능 차이

- YOLOv8 + CSPDarknet(백본) → 실시간 속도와 높은 정확도의 균형

- YOLO(You Only Look Once) 계열의 모델은 한 번의 네트워크 연산으로 객체를 탐지하는 구조다.

- 비교적 최신 버전인 YOLOv8은 CSPDarknet이라는 백본을 사용하여, 속도와 정확도를 동시에 잡았다.

- 적용 사례: 실시간 자동차 번호판 인식, CCTV 모니터링, 스포츠 경기 분석 등

- Faster R-CNN + ResNet(백본) → 높은 정확도

- Faster R-CNN은 2단계 방식(Two-stage) 탐지 모델로, 먼저 후보 영역(Region Proposal)을 찾고, 이후 정확한 분류를 수행하는 방식이다.

- 따라서 백본의 특징 추출 능력이 매우 중요하며, 주로 ResNet을 사용하여 높은 정확도를 보장한다.

- 적용 사례: 의료 영상 분석(CT/MRI), 정밀한 객체 탐지(위성 이미지 분석, 자율주행 차량 감지)

- SSD + MobileNet(백본) → 경량 모델로 빠른 속도

- SSD(Single Shot Detector)는 YOLO와 비슷한 단일 단계 탐지 모델이지만, 여러 크기의 박스를 활용하는 구조를 갖는다.

- 백본으로 MobileNet을 사용하면 모바일 환경에서도 실행할 수 있는 가벼운 모델이 된다.

- 적용 사례: 스마트폰 얼굴 인식, 로봇 비전, 드론 카메라 탐지

백본 선택이 탐지 모델에 미치는 영향

백본을 바꾸는 것만으로도 모델의 성능이 크게 변화할 수 있다.

예를 들어, 같은 Faster R-CNN 모델이라도 백본을 VGG → ResNet → Swin Transformer 순으로 바꾸면

다음과 같은 차이가 나타난다.

| 백본 | 속도(FPS) | 정확도(mAP) |

| VGG | 느림 | 보통 |

| ResNet | 보통 | 높음 |

| Swin Transformer | 빠름 | 매우 높음 |

최신 연구에서는 기존 CNN 기반 백본 대신,

Swin Transformer 같은 트랜스포머 기반 백본이 등장하면서 더 뛰어난 성능을 내고 있다.

결론적으로, 객체 탐지 모델의 성능을 최적화하려면 백본을 상황에 맞게 선택하는 것이 중요하다.

가벼운 모델이 필요하면 MobileNet을, 높은 정확도가 필요하면 ResNet이나 Swin Transformer를 활용하면 된다.

정리 1 : 백본이 중요한 이유

- 좋은 특징 뽑기가 가장 중요하다. → 특징 뽑기를 잘해야 뒷단에서 위치와 클래스를 정확히 예측한다.

- 속도와 정확도의 균형을 조절한다. → 무거운 백본: 정확하지만 느림 (ResNet, VGG) → 가벼운 백본: 빠르지만 정확도 조금 낮음 (MobileNet)

- 백본 선택에 따라 모델 성능이 달라진다. → 최신 대회나 논문에서는 백본 교체만으로도 성능 향상을 보여주는 경우가 많다.

정리 2: 백본 선택 시 고려사항

- 속도가 중요한가? 정확도가 중요한가?

- 속도: MobileNet, ShuffleNet

- 정확도: ResNet, EfficientNet

- 운영 환경

- 모바일, 임베디드 → MobileNet, EfficientNet-Lite

- 서버, GPU → ResNet, DenseNet, EfficientNet

요약

| 개념 | 설명 |

| 백본 | 이미지 특징(Feature)을 뽑아주는 신경망의 초기 부분 |

| 특징맵 | 백본이 뽑아낸 시각적 정보 |

| 유명 백본 | VGG, ResNet, MobileNet, EfficientNet |

| 속도 | MobileNet > ResNet > VGG |

| 정확도 | EfficientNet > ResNet > VGG > MobileNet |

비전 인공지능에서는 좋은 백본을 선택하는 것이 성능의 절반을 결정한다고 해도 과언이 아니다.

“강한 뇌보다, 먼저 좋은 눈이 필요하다”는 점을 잊지 말자.

백본 선택에 따라 속도와 정확도가 달라지므로, 내 상황에 맞는 백본을 고르는 눈을 기르자.

'ML+DL > Vision AI' 카테고리의 다른 글

| CNN(합성곱 신경망)의 수학적 원리와 단계별 계산 (0) | 2025.03.15 |

|---|---|

| 활성화 함수와는 다르다! 활성화 함수와는! 소프트맥스(Softmax)함수 (0) | 2025.03.14 |

| CNN에서 활성화 함수가 여러번 적용되는 이유 (0) | 2025.03.11 |

| NMS(Non-Maximum Suppression) 알고리즘 이해하기 (0) | 2025.02.18 |

| 객체 탐지 평가 지표: Precision, Recall, mAP, F1 Score 완전 이해하기 (0) | 2025.02.18 |

| 컴퓨터 비전과 객체 인식: YOLO 모델과 평가 지표에 대한 이해 (0) | 2025.01.21 |

- Total

- Today

- Yesterday

- 남미

- BOJ

- 동적계획법

- java

- 스프링

- 면접 준비

- 파이썬

- 중남미

- 유럽

- 야경

- Python

- 칼이사

- 스트림

- 백준

- a6000

- Backjoon

- 맛집

- 여행

- Algorithm

- 세계여행

- 세계일주

- 자바

- 알고리즘

- RX100M5

- 세모

- 기술면접

- spring

- 지지

- 리스트

- 유럽여행

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |