티스토리 뷰

목차

[선형대수학]머신러닝과 딥 러닝의 핵심, 선형대수학의 역할과 중요성

[선형대수학]부분행렬과 분할행렬: 공통점과 차이점, ML/DL에의 응용

[선형대수학]역행렬과 행렬식의 성질, ML/DL과의 관계

[선형대수학]행렬의 해와 감소된 행 계단형(Reduced Row Echelon Form, RREF)

[선형대수학]벡터 공간과 기저, 차원 그리고 ML/DL

[선형대수학]선형변환과 고윳값의 이해: 머신러닝/딥러닝에서의 응용

[선형대수학]벡터 공간의 대각화와 그 응용 - 유사 행렬 및 머신러닝에서의 중요성

[선형대수학]특이값 분해(SVD): 기본부터 머신러닝/딥러닝까지의 응용

[선형대수학]실 이차 형식과 양의 정부호 행렬: 머신러닝/딥러닝에의 응용

Introduction

벡터의 내적은 기하학적으로 벡터들 간의 각도를 계산하고, 대수적으로는 데이터의 유사성을 측정하는 데 사용된다.

이는 머신러닝과 딥러닝에서 패턴 인식 및 분류 문제를 해결하는 데 필수적인 도구로 활용된다.

이 글에서는 벡터의 길이, 벡터 간의 거리, 코사인 법칙을 통해 내적을 정의하고,

내적 공간, Orthogonal set의 특성, 그리고 이러한 개념들이 어떻게 데이터의 유사성 판별에 사용되는지를 탐구한다.

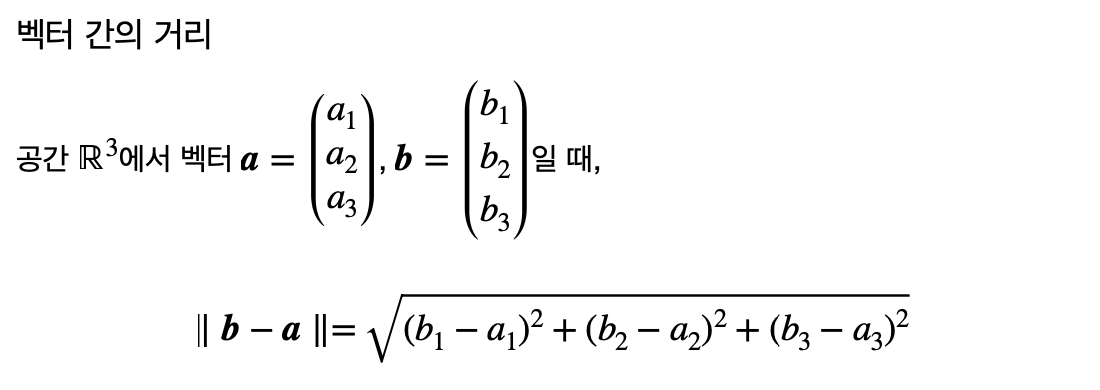

Vector Length and Distance

벡터 a의 길이는 ‖로 계산되며, 이는 유클리드 공간에서의 norm에 해당한다.

두 벡터 a와 b 사이의 거리는 \left\|b-a\right\|로 계산되며, 이는 두 벡터가 이루는 직선의 최단 경로의 길이를 나타낸다.

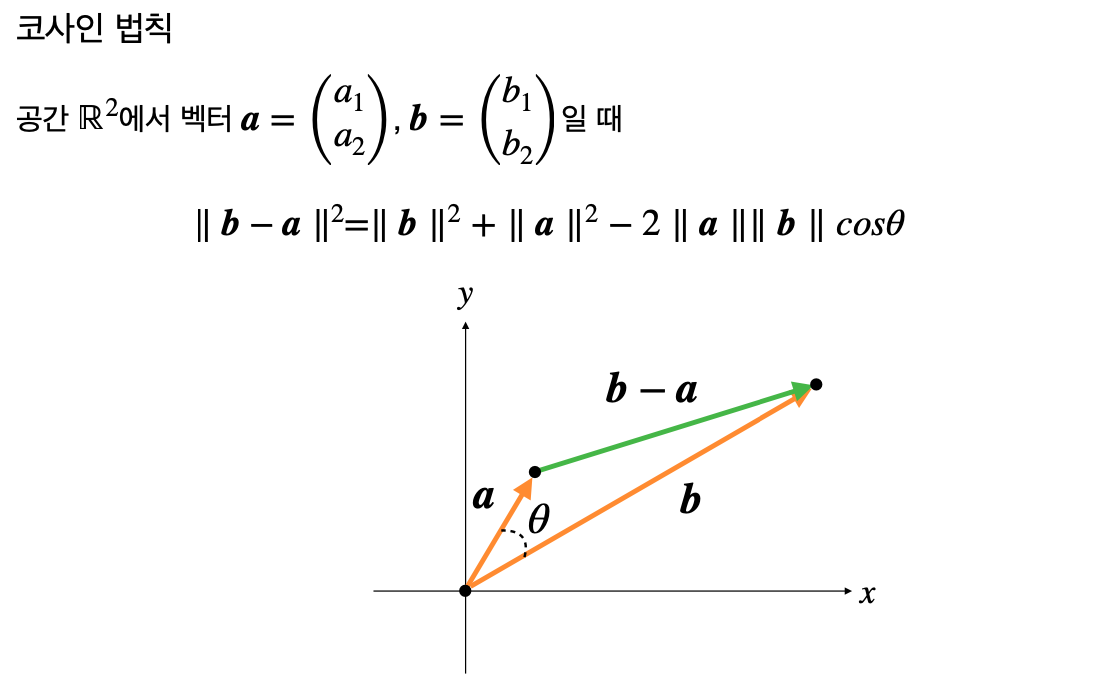

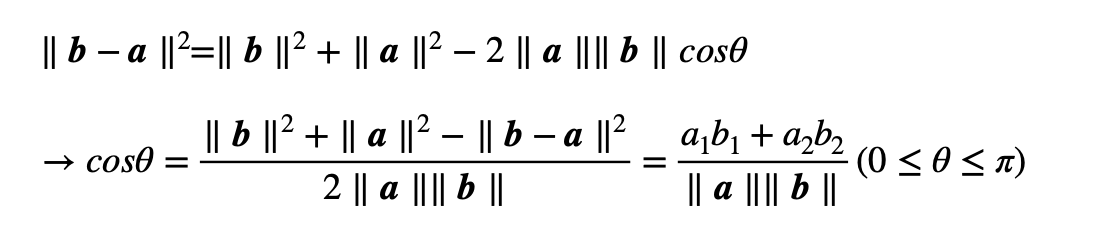

Cosine Law and Dot Product

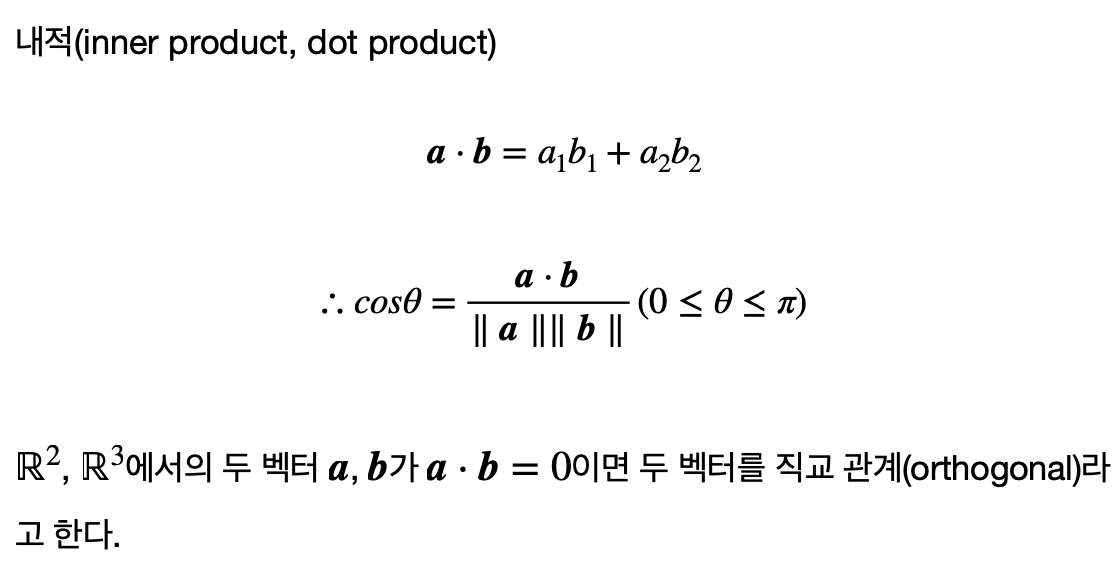

코사인 법칙에 의해 두 벡터 a와 b 사이의 각도 θ는 내적을 통해 \cos \theta = \frac{a\cdot b}{\left\|a\right\|\left\|b\right\|}로 정의된다.

내적 a⋅b는 벡터의 성분별 곱의 합으로 계산되며, 이는 두 벡터의 방향성과 크기가 얼마나 일치하는지를 측정한다.

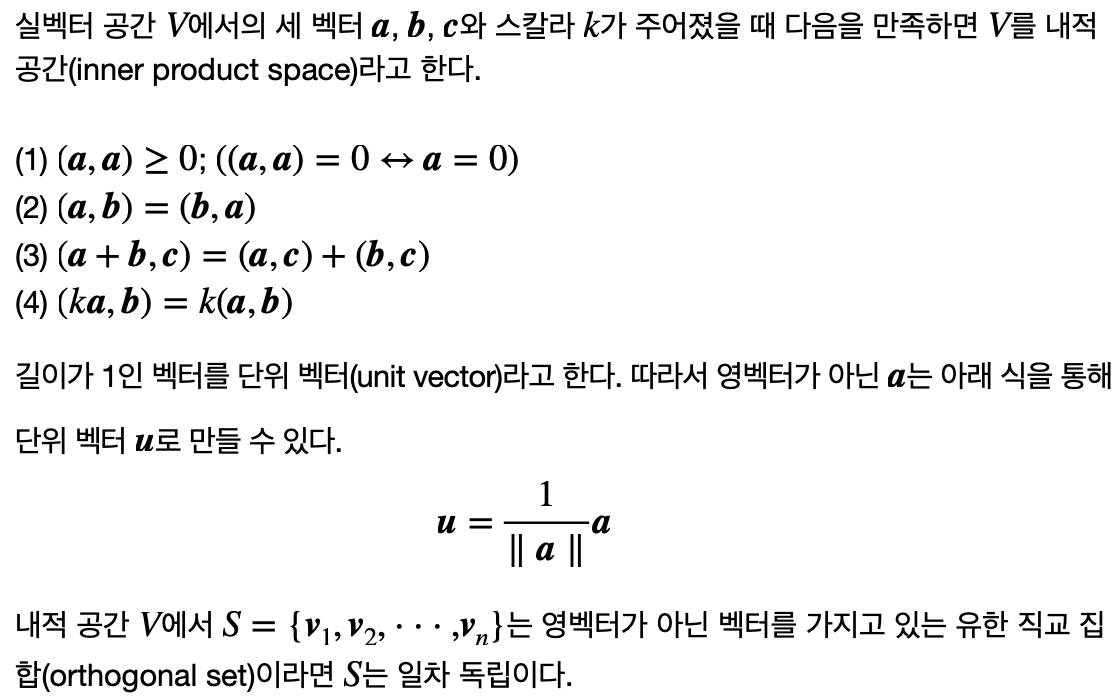

Inner Product Space and Orthogonal Set

내적 공간은 벡터 공간에 내적 연산이 추가된 구조를 가지며,

이를 통해 벡터의 길이, 두 벡터 사이의 각도, 그리고 직교성(orthogonality)을 정의할 수 있다.

내적이 정의된 공간에서는 벡터의 길이를 norm으로 측정하고,

두 벡터의 내적을 통해 코사인 각도를 계산하여, 두 벡터 사이의 방향성과 관련성을 파악한다.

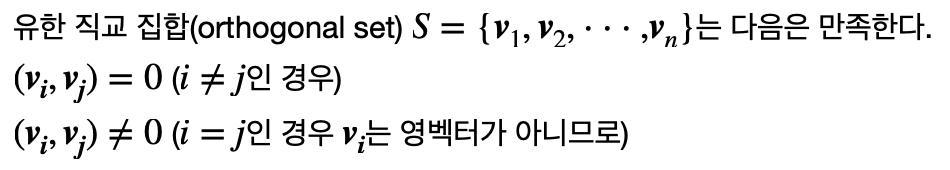

Orthogonal set은 그러한 내적 공간에서 서로 직교(orthogonal)하는 벡터들의 집합으로,

이는 서로 독립적인 방향을 가진 벡터들로 구성된다.

이 집합의 벡터들은 데이터를 서로 독립적인 축으로 분해하여 분석하는 데 사용되며,

이는 고차원 데이터를 이해하고, 차원 축소와 같은 복잡한 문제를 해결하는 데 매우 유용하다.

ML/DL

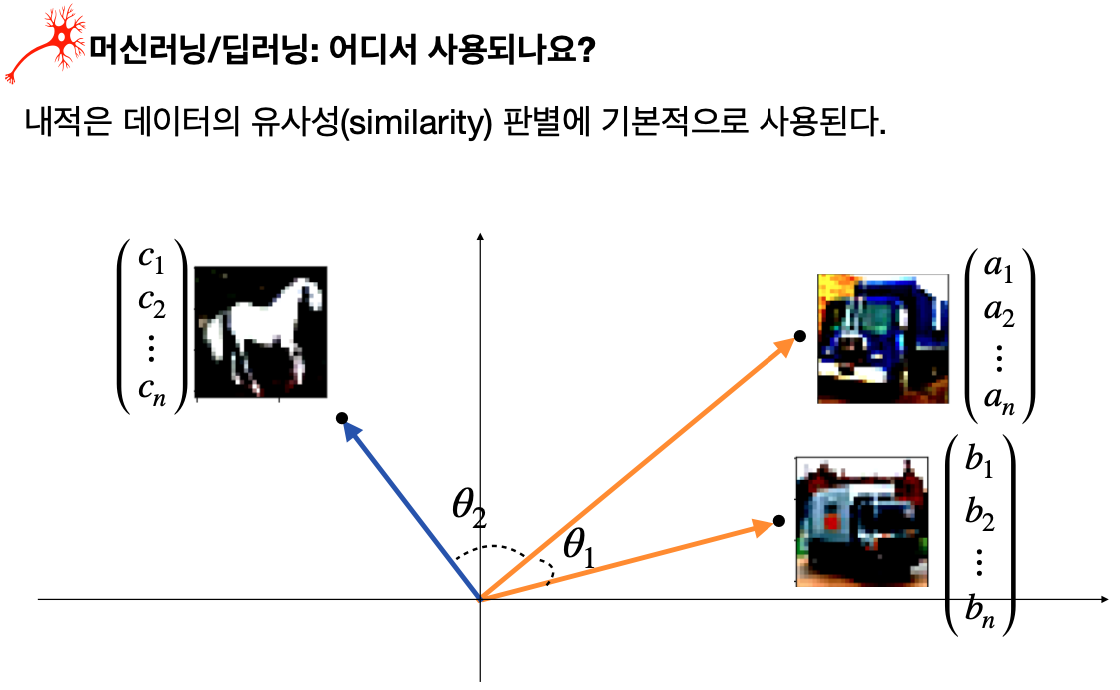

데이터의 유사성 판별에 내적은 필수적인 도구로 사용된다.

예를 들어, 문서 분류나 추천 시스템에서 각 항목을 벡터로 표현하고,

이들 벡터의 내적을 계산하여 유사성을 측정할 수 있다.

벡터 간의 내적 값이 크면 클수록 두 벡터는 유사한 방향을 가리키고, 유사한 특성을 공유한다고 볼 수 있다.

반면, 내적 값이 0에 가까우면 두 벡터는 서로 독립적이거나 직교하는 관계에 있다고 해석할 수 있다.

이러한 성질을 활용하여, 머신러닝과 딥러닝에서는 데이터 포인트들 사이의 관계를 분석하고,

패턴을 인식하며, 예측 모델을 구축하는 데 중요한 역할을 한다.

Conclusion

벡터의 내적과 내적 공간의 개념은 수학적 추상에서 실용적 응용에 이르기까지 다양한 분야에서 활용된다.

이러한 개념들은 데이터의 기본적인 특성을 분석하고 복잡한 데이터 구조를 이해하는 데 매우 중요하다.

데이터 과학, 머신러닝, 딥러닝에서 내적과 관련된 개념들을 이해하고 활용함으로써,

우리는 데이터 기반 의사 결정을 더욱 정확하고 효율적으로 수행할 수 있다.

지속적인 연구와 실습을 통해, 벡터 내적의 실용적인 이해를 넓히고 그 응용 범위를 확장해 나가는 것이 중요하다.

'ML+DL > Linear Algebra' 카테고리의 다른 글

| [선형대수학]선형변환과 고윳값의 이해: 머신러닝/딥러닝에서의 응용 (0) | 2024.02.19 |

|---|---|

| [선형대수학]최소 제곱해 (0) | 2024.02.16 |

| [선형대수학]정규직교 기저와 그람-슈미트 프로세스 (0) | 2024.02.14 |

| [선형대수학]행렬의 랭크와 그 응용 (0) | 2024.02.09 |

| [선형대수학]차원의 저주: 데이터 분석의 걸림돌 (0) | 2024.02.08 |

| [선형대수학]벡터 공간과 기저, 차원 그리고 ML/DL (0) | 2024.02.07 |

- Total

- Today

- Yesterday

- 자바

- 유럽여행

- 면접 준비

- 유럽

- Python

- 스프링

- 지지

- java

- 칼이사

- 기술면접

- spring

- RX100M5

- 리스트

- 중남미

- 야경

- 맛집

- 동적계획법

- 세모

- 여행

- 스트림

- 알고리즘

- Backjoon

- Algorithm

- BOJ

- 세계일주

- 남미

- 세계여행

- 파이썬

- a6000

- 백준

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |